Les chercheurs du MIT ont développé un modèle d’apprentissage automatique qui comprend les relations sous-jacentes entre les objets d’une scène et peut générer des images précises de scènes à partir de descriptions textuelles. Crédit : Jose-Luis Olivares, MIT et iStockphoto

Un nouveau modèle d’apprentissage automatique pourrait permettre aux robots de comprendre les interactions dans le monde à la manière des humains.

Lorsque les humains regardent une scène, ils voient des objets et les relations entre eux. Au-dessus de votre bureau, il peut y avoir un ordinateur portable qui se trouve à gauche d’un téléphone, devant un écran d’ordinateur.

De nombreux modèles d’apprentissage en profondeur ont du mal à voir le monde de cette façon, car ils ne comprennent pas les relations intriquées entre les objets individuels. Sans connaissance de ces relations, un robot conçu pour aider quelqu’un dans une cuisine aurait du mal à suivre une commande comme « prendre la spatule qui se trouve à gauche de la cuisinière et la placer sur la planche à découper ».

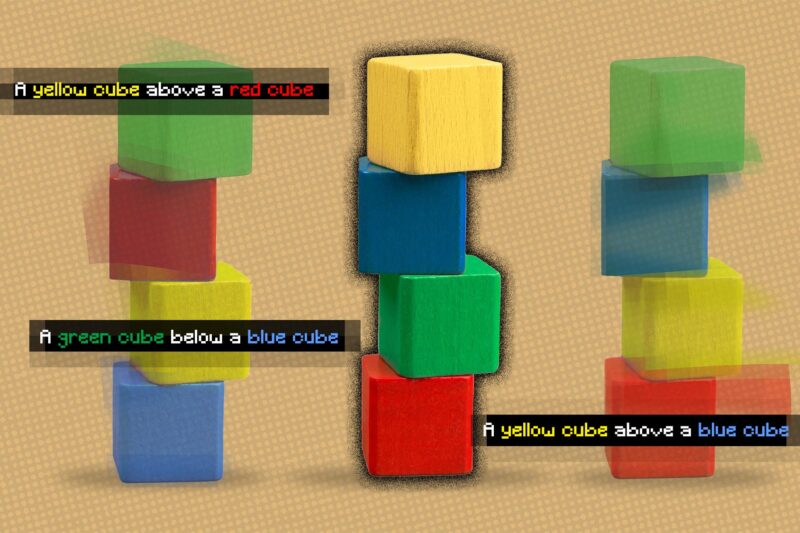

Dans un effort pour résoudre ce problème, AVEC les chercheurs ont développé un modèle qui comprend les relations sous-jacentes entre les objets d’une scène. Leur modèle représente les relations individuelles une à la fois, puis combine ces représentations pour décrire la scène globale. Cela permet au modèle de générer des images plus précises à partir de descriptions textuelles, même lorsque la scène comprend plusieurs objets disposés dans des relations différentes les uns par rapport aux autres.

Ce travail pourrait être appliqué dans des situations où les robots industriels doivent effectuer des tâches de manipulation complexes en plusieurs étapes, comme empiler des articles dans un entrepôt ou assembler des appareils. Cela rapproche également le domaine de la mise en place de machines capables d’apprendre de leur environnement et d’interagir avec celui-ci davantage comme le font les humains.

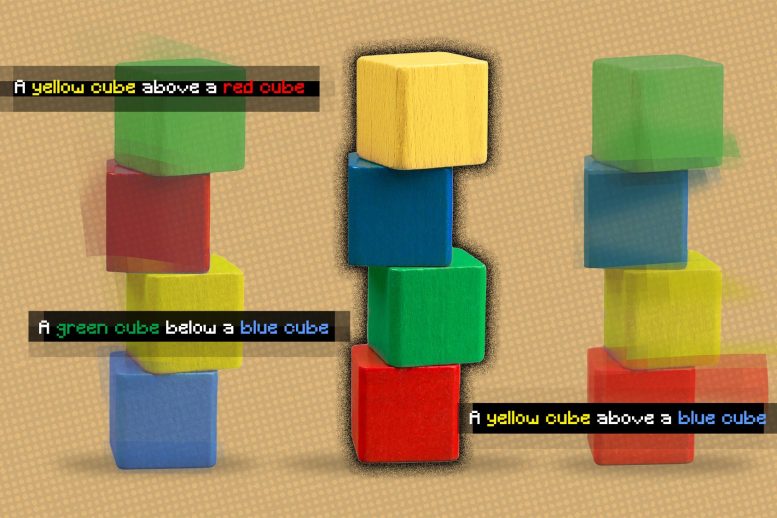

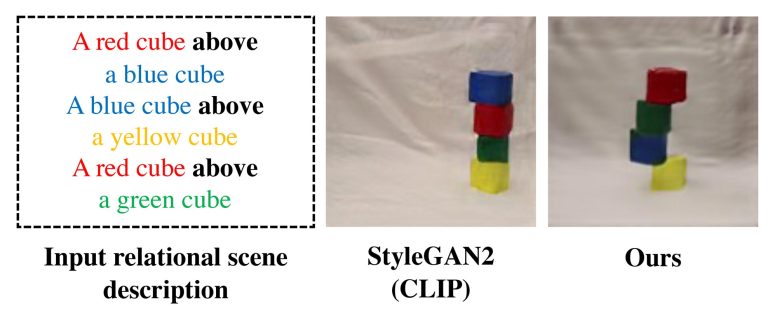

Le cadre que les chercheurs ont développé peut générer une image d’une scène basée sur une description textuelle des objets et de leurs relations. Dans cette figure, l’image finale des chercheurs est à droite et suit correctement la description textuelle. Crédit : Avec l’aimable autorisation des chercheurs

« Quand je regarde une table, je ne peux pas dire qu’il y a un objet à l’emplacement XYZ. Nos esprits ne fonctionnent pas comme ça. Dans notre esprit, lorsque nous comprenons une scène, nous la comprenons vraiment en fonction des relations entre les objets. Nous pensons qu’en construisant un système capable de comprendre les relations entre les objets, nous pourrions utiliser ce système pour manipuler et modifier plus efficacement nos environnements », explique Yilun Du, doctorant au Laboratoire d’informatique et d’intelligence artificielle (CSAIL) et co. -auteur principal de l’article.

Du a écrit l’article avec les co-auteurs principaux Shuang Li, doctorant au CSAIL, et Nan Liu, étudiante diplômée à l’Université de l’Illinois à Urbana-Champaign ; ainsi que Joshua B. Tenenbaum, professeur Paul E. Newton en développement de carrière en sciences cognitives et calcul au Département des sciences du cerveau et des sciences cognitives et membre du CSAIL ; et l’auteur principal Antonio Torralba, le professeur Delta Electronics de génie électrique et d’informatique et membre de CSAIL. La recherche sera présentée à la Conférence sur les systèmes de traitement de l’information neuronale en décembre.

Une relation à la fois

Le cadre que les chercheurs ont développé peut générer une image d’une scène basée sur une description textuelle des objets et de leurs relations, comme « Une table en bois à gauche d’un tabouret bleu. Un canapé rouge à droite d’un tabouret bleu.

Leur système décomposerait ces phrases en deux morceaux plus petits décrivant chaque relation individuelle (« une table en bois à gauche d’un tabouret bleu » et « un canapé rouge à droite d’un tabouret bleu »), puis modéliserait chaque partie séparément . Ces pièces sont ensuite combinées via un processus d’optimisation qui génère une image de la scène.

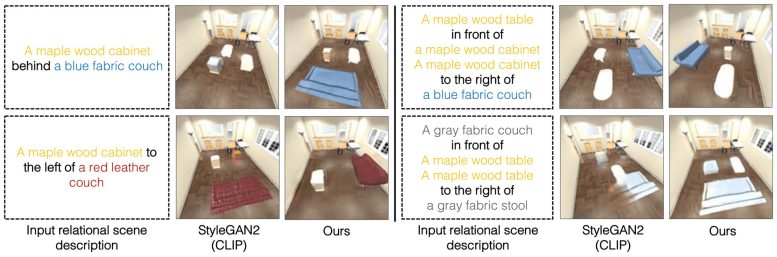

Dans cette figure, les images finales du chercheur sont étiquetées « les nôtres ». Crédit : Avec l’aimable autorisation des chercheurs

Les chercheurs ont utilisé une technique d’apprentissage automatique appelée modèles basés sur l’énergie pour représenter les relations d’objets individuels dans une description de scène. Cette technique leur permet d’utiliser un modèle basé sur l’énergie pour coder chaque description relationnelle, puis de les composer ensemble de manière à déduire tous les objets et toutes les relations.

En décomposant les phrases en morceaux plus courts pour chaque relation, le système peut les recombiner de diverses manières, il est donc mieux à même de s’adapter aux descriptions de scènes qu’il n’a jamais vues auparavant, explique Li.

« D’autres systèmes prendraient toutes les relations de manière holistique et généreraient l’image unique à partir de la description. Cependant, de telles approches échouent lorsque nous avons des descriptions hors distribution, telles que des descriptions avec plus de relations, car ces modèles ne peuvent pas vraiment adapter un plan pour générer des images contenant plus de relations. Cependant, alors que nous composons ensemble ces modèles séparés et plus petits, nous pouvons modéliser un plus grand nombre de relations et nous adapter à de nouvelles combinaisons », explique Du.

Le système fonctionne également à l’envers : à partir d’une image, il peut trouver des descriptions textuelles qui correspondent aux relations entre les objets de la scène. De plus, leur modèle peut être utilisé pour éditer une image en réorganisant les objets de la scène afin qu’ils correspondent à une nouvelle description.

Comprendre des scènes complexes

Les chercheurs ont comparé leur modèle à d’autres méthodes d’apprentissage en profondeur qui ont reçu des descriptions textuelles et chargées de générer des images qui affichent les objets correspondants et leurs relations. Dans chaque cas, leur modèle a surpassé les lignes de base.

Ils ont également demandé aux humains d’évaluer si les images générées correspondaient à la description de la scène originale. Dans les exemples les plus complexes, où les descriptions contenaient trois relations, 91 % des participants ont conclu que le nouveau modèle fonctionnait mieux.

“Une chose intéressante que nous avons trouvée est que pour notre modèle, nous pouvons augmenter notre phrase d’avoir une description de relation à avoir deux, ou trois, ou même quatre descriptions, et notre approche continue à être capable de générer des images qui sont correctement décrites par ces descriptions, tandis que d’autres méthodes échouent », explique Du.

Les chercheurs ont également montré les images modèles de scènes qu’ils n’avaient jamais vues auparavant, ainsi que plusieurs descriptions textuelles différentes de chaque image, et ils ont pu identifier avec succès la description qui correspondait le mieux aux relations entre les objets dans l’image.

Et lorsque les chercheurs ont donné au système deux descriptions de scènes relationnelles décrivant la même image mais de manières différentes, le modèle a pu comprendre que les descriptions étaient équivalentes.

Les chercheurs ont été impressionnés par la robustesse de leur modèle, en particulier lorsqu’ils travaillaient avec des descriptions qu’il n’avait jamais rencontrées auparavant.

« C’est très prometteur parce que c’est plus proche de la façon dont les humains fonctionnent. Les humains peuvent ne voir que plusieurs exemples, mais nous pouvons extraire des informations utiles de ces quelques exemples et les combiner pour créer des combinaisons infinies. Et notre modèle a une telle propriété qui lui permet d’apprendre à partir de moins de données mais de se généraliser à des scènes ou des générations d’images plus complexes », explique Li.

Bien que ces premiers résultats soient encourageants, les chercheurs aimeraient voir comment leur modèle fonctionne sur des images du monde réel plus complexes, avec des arrière-plans bruyants et des objets qui se bloquent les uns les autres.

Ils sont également intéressés à éventuellement incorporer leur modèle dans des systèmes robotiques, permettant à un robot de déduire des relations d’objets à partir de vidéos, puis d’appliquer ces connaissances pour manipuler des objets dans le monde.

« Développer des représentations visuelles capables de gérer la nature compositionnelle du monde qui nous entoure est l’un des principaux problèmes ouverts de la vision par ordinateur. Cet article fait des progrès significatifs sur ce problème en proposant un modèle basé sur l’énergie qui modélise explicitement les relations multiples entre les objets représentés dans l’image. Les résultats sont vraiment impressionnants », déclare Josef Sivic, éminent chercheur à l’Institut tchèque d’informatique, de robotique et de cybernétique de l’Université technique tchèque, qui n’a pas participé à cette recherche.

Référence : « Apprendre à composer des relations visuelles » par Nan Liu, Shuang Li, Yilun Du, Joshua B. Tenenbaum et Antonio Torralba, NeurIPS 2021 (Spotlight).

GitHub

Cette recherche est financée, en partie, par Raytheon BBN Technologies Corp., Mitsubishi Electric Research Laboratory, la National Science Foundation, l’Office of Naval Research et le IBM Thomas J. Watson Research Center.