De la vapeur à l’électricité en passant par les ordinateurs et Internet, les progrès technologiques ont toujours perturbé les marchés du travail, supprimant certains emplois tout en en créant d’autres. L’intelligence artificielle reste un terme impropre – les systèmes informatiques les plus intelligents ne savent toujours rien – mais la technologie a atteint un point d’inflexion où elle est sur le point d’affecter de nouvelles catégories d’emplois : les artistes et les travailleurs du savoir.

Créativité pour tous – mais perte de compétences ?

Lynne Parker, vice-chancelière associée, Université du Tennessee

Les grands modèles linguistiques rendent la créativité et le savoir-faire accessibles à tous. Toute personne disposant d’une connexion Internet peut désormais utiliser des outils comme ChatGPT ou DALL-E 2 pour s’exprimer et donner du sens à d’immenses réserves d’informations, par exemple en produisant des résumés de texte.

La profondeur de l’expertise humaine que les grands modèles de langage affichent est particulièrement remarquable. En quelques minutes, les novices peuvent créer des illustrations pour leurs présentations commerciales, générer des argumentaires marketing, obtenir des idées pour surmonter le blocage de l’écrivain ou générer un nouveau code informatique pour exécuter des fonctions spécifiques, le tout à un niveau de qualité généralement attribué aux experts humains.

Ces nouveaux outils d’IA ne peuvent pas lire dans les pensées, bien sûr. Un nouveau type de créativité humaine, mais plus simple, est nécessaire sous la forme d’invites textuelles pour obtenir les résultats recherchés par l’utilisateur humain. Grâce à l’incitation itérative – un exemple de collaboration homme-IA – le système d’IA génère des séries successives de sorties jusqu’à ce que l’humain écrivant les invites soit satisfait des résultats. Par exemple, le gagnant (humain) du récent concours Colorado State Fair dans la catégorie des artistes numériques, qui a utilisé un outil alimenté par l’IA, a fait preuve de créativité, mais pas du genre qui nécessite des pinceaux et un œil pour la couleur et la texture.

S’il y a des avantages significatifs à ouvrir le monde de la créativité et du travail intellectuel à tous, ces nouveaux outils d’IA ont aussi des inconvénients. Premièrement, ils pourraient accélérer la perte de compétences humaines importantes qui resteront importantes dans les années à venir, en particulier les compétences en écriture. Les établissements d’enseignement doivent élaborer et appliquer des politiques sur les utilisations autorisées de grands modèles linguistiques pour garantir le fair-play et les résultats d’apprentissage souhaitables.

Deuxièmement, ces outils d’IA soulèvent des questions sur la protection de la propriété intellectuelle. Alors que les créateurs humains s’inspirent régulièrement d’artefacts existants dans le monde, y compris l’architecture et les écrits, la musique et les peintures d’autrui, il reste des questions sans réponse sur l’utilisation appropriée et équitable par de grands modèles linguistiques d’exemples de formation protégés par le droit d’auteur ou open source. Des procès en cours débattent actuellement de cette question, ce qui pourrait avoir des implications pour la conception et l’utilisation futures de grands modèles de langage.

Alors que la société navigue dans les implications de ces nouveaux outils d’IA, le public semble prêt à les adopter. Le chatbot ChatGPT est rapidement devenu viral, tout comme le générateur d’images Dall-E mini et d’autres. Cela suggère un énorme potentiel inexploité de créativité et l’importance de rendre le travail créatif et intellectuel accessible à tous.

Inexactitudes, biais et plagiat potentiels

Daniel Acuña, professeur agrégé d’informatique, Université du Colorado à Boulder

Je suis un utilisateur régulier de GitHub Copilot, un outil pour aider les gens à écrire du code informatique, et j’ai passé d’innombrables heures à jouer avec ChatGPT et des outils similaires pour le texte généré par l’IA. D’après mon expérience, ces outils sont bons pour explorer des idées auxquelles je n’avais pas pensé auparavant.

J’ai été impressionné par la capacité des modèles à traduire mes instructions en texte ou code cohérent. Ils sont utiles pour découvrir de nouvelles façons d’améliorer le flux de mes idées ou de créer des solutions avec des progiciels dont j’ignorais l’existence. Une fois que je vois ce que ces outils génèrent, je peux évaluer leur qualité et modifier fortement. Dans l’ensemble, je pense qu’ils élèvent la barre sur ce qui est considéré comme créatif.

Mais j’ai plusieurs réserves.

Un ensemble de problèmes est leurs inexactitudes – petites et grandes. Avec Copilot et ChatGPT, je recherche constamment si les idées sont trop superficielles – par exemple, un texte sans beaucoup de substance ou un code inefficace, ou une sortie tout simplement fausse, comme des analogies ou des conclusions erronées, ou un code qui ne fonctionne pas. Si les utilisateurs ne critiquent pas ce que ces outils produisent, les outils sont potentiellement dangereux.

Récemment, Meta a fermé son grand modèle de langage Galactica pour les textes scientifiques parce qu’il inventait des “faits” mais semblait très confiant. Le souci était que cela pourrait polluer Internet avec des mensonges à consonance confiante.

Un autre problème est celui des préjugés. Les modèles de langage peuvent apprendre des biais des données et les reproduire. Ces biais sont difficiles à voir dans la génération de texte mais très clairs dans les modèles de génération d’images. Les chercheurs d’OpenAI, créateurs de ChatGPT, ont été relativement prudents quant à ce à quoi le modèle répondra, mais les utilisateurs trouvent régulièrement des moyens de contourner ces garde-fous.

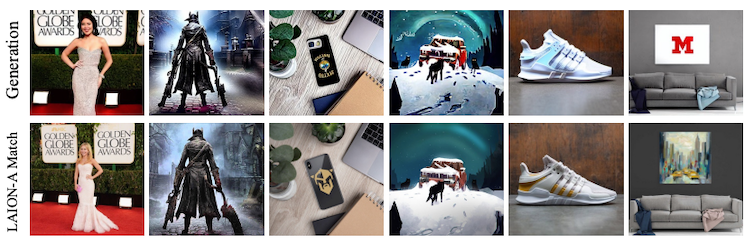

Un autre problème est le plagiat. Des recherches récentes ont montré que les outils de génération d’images plagient souvent le travail des autres. Est-ce la même chose avec ChatGPT ? Je crois que nous ne savons pas. L’outil pourrait paraphraser ses données de formation – une forme avancée de plagiat. Les travaux dans mon laboratoire montrent que les outils de détection de plagiat de texte sont loin derrière lorsqu’il s’agit de détecter la paraphrase.

Le plagiat est plus facile à voir dans les images que dans le texte. ChatGPT paraphrase-t-il également ? Somepalli, G., et al., CC BY

Ces outils n’en sont qu’à leurs balbutiements, compte tenu de leur potentiel. Pour l’instant, je pense qu’il existe des solutions à leurs limitations actuelles. Par exemple, les outils pourraient vérifier les faits du texte généré par rapport aux bases de connaissances, utiliser des méthodes mises à jour pour détecter et supprimer les biais des grands modèles de langage et exécuter les résultats via des outils de détection de plagiat plus sophistiqués.

Avec les humains dépassés, les emplois de niche et “faits à la main” resteront

Kentaro Toyama, professeur d’information communautaire, Université du Michigan

Nous, les êtres humains, aimons croire en notre spécificité, mais la science et la technologie ont maintes fois prouvé que cette conviction était fausse. Les gens pensaient autrefois que les humains étaient les seuls animaux à utiliser des outils, à former des équipes ou à propager la culture, mais la science a montré que d’autres animaux font chacune de ces choses.

Pendant ce temps, la technologie a annulé, une par une, les affirmations selon lesquelles les tâches cognitives nécessitent un cerveau humain. La première machine à additionner a été inventée en 1623. L’année dernière, une œuvre générée par ordinateur a remporté un concours d’art. Je crois que la singularité – le moment où les ordinateurs rencontrent et dépassent l’intelligence humaine – est à l’horizon.

Comment l’intelligence et la créativité humaines seront-elles valorisées lorsque les machines deviendront plus intelligentes et plus créatives que les personnes les plus brillantes ? Il y aura probablement un continuum. Dans certains domaines, les gens apprécient toujours que les humains fassent des choses, même si un ordinateur peut le faire mieux. Cela fait un quart de siècle que Deep Blue d’IBM a battu le champion du monde Garry Kasparov, mais les échecs humains – avec tout leur drame – n’ont pas disparu.

Dans d’autres domaines, la compétence humaine semblera coûteuse et étrangère. Prenons l’illustration, par exemple. Pour la plupart, les lecteurs ne se soucient pas de savoir si le graphique accompagnant un article de magazine a été dessiné par une personne ou un ordinateur – ils veulent juste qu’il soit pertinent, nouveau et peut-être divertissant. Si un ordinateur peut bien dessiner, les lecteurs se soucient-ils de savoir si la ligne de crédit indique Mary Chen ou System X ? Les illustrateurs le feraient, mais les lecteurs pourraient même ne pas le remarquer.

Et, bien sûr, cette question n’est pas noire ou blanche. De nombreux champs seront hybrides, où certains Homo sapiens trouver un créneau chanceux, mais la plupart du travail est effectué par des ordinateurs. Pensez à la fabrication – une grande partie est aujourd’hui réalisée par des robots, mais certaines personnes supervisent les machines, et il reste un marché pour les produits faits à la main.

Si l’histoire est un guide, il est presque certain que les progrès de l’IA feront disparaître davantage d’emplois, que les personnes de la classe créative dotées de compétences uniquement humaines deviendront plus riches mais moins nombreuses, et que ceux qui possèdent la technologie créative deviendront le nouveau méga -riche. S’il y a une lueur d’espoir, c’est peut-être que lorsque encore plus de personnes sont sans moyens de subsistance décents, les gens pourraient rassembler la volonté politique de contenir les inégalités galopantes.

Les anciens emplois disparaîtront, de nouveaux emplois apparaîtront

Mark Finlayson, professeur agrégé d’informatique, Université internationale de Floride

Les grands modèles de langage sont des machines de complétion de séquences sophistiquées : donnez-en une à une séquence de mots (« je voudrais manger un… ») et elle renverra des complétions probables (« … pomme. »). Les grands modèles de langage comme ChatGPT qui ont été formés sur un nombre record de mots (des billions) en ont surpris beaucoup, y compris de nombreux chercheurs en IA, par le réalisme, l’étendue, la flexibilité et la sensibilité au contexte de leurs complétions.

Comme toute nouvelle technologie puissante qui automatise une compétence – dans ce cas, la génération d’un texte cohérent, quoique quelque peu générique -, cela affectera ceux qui offrent cette compétence sur le marché. Pour concevoir ce qui pourrait arriver, il est utile de rappeler l’impact de l’introduction des programmes de traitement de texte au début des années 1980. Certains métiers comme dactylographe ont presque complètement disparu. Mais, en revanche, toute personne disposant d’un ordinateur personnel était capable de générer facilement des documents bien composés, ce qui augmentait considérablement la productivité.

De plus, de nouveaux emplois et compétences sont apparus qui étaient auparavant inimaginables, comme l’élément de CV souvent inclus MS Office. Et le marché de la production de documents haut de gamme est resté, devenant beaucoup plus performant, sophistiqué et spécialisé.

Je pense que ce même schéma s’appliquera presque certainement aux grands modèles de langage : vous n’aurez plus besoin de demander à d’autres personnes de rédiger un texte cohérent et générique. D’autre part, les grands modèles linguistiques permettront de nouvelles façons de travailler et conduiront également à de nouveaux emplois encore inimaginables.

Pour voir cela, considérez seulement trois aspects où les grands modèles de langage échouent. Tout d’abord, il peut falloir beaucoup d’intelligence (humaine) pour créer une invite qui obtient le résultat souhaité. Des modifications mineures dans l’invite peuvent entraîner une modification majeure de la sortie.

Deuxièmement, les grands modèles de langage peuvent générer une sortie inappropriée ou absurde sans avertissement.

Troisièmement, pour autant que les chercheurs en IA puissent le dire, les grands modèles de langage n’ont pas de compréhension abstraite et générale de ce qui est vrai ou faux, si quelque chose est bien ou mal, et ce qui relève du bon sens. Notamment, ils ne peuvent pas faire des calculs relativement simples. Cela signifie que leur sortie peut inopinément être trompeuse, biaisée, logiquement erronée ou tout simplement fausse.

Ces échecs sont des opportunités pour les travailleurs créatifs et intellectuels. Pour une grande partie de la création de contenu, même pour le grand public, les gens auront toujours besoin du jugement de créateurs humains et de travailleurs du savoir pour inciter, guider, rassembler, organiser, éditer et surtout augmenter la production des machines. De nombreux types de langages spécialisés et hautement techniques resteront hors de portée des machines dans un avenir prévisible. Et il y aura de nouveaux types de travail – par exemple, ceux qui feront une entreprise en peaufinant de grands modèles linguistiques internes pour générer certains types de texte spécialisés pour servir des marchés particuliers.

En somme, bien que les grands modèles linguistiques annoncent certainement des perturbations pour les créateurs et les travailleurs du savoir, il existe encore de nombreuses opportunités intéressantes pour ceux qui souhaitent s’adapter et intégrer ces puissants nouveaux outils.

Les progrès technologiques mènent à de nouvelles compétences

Casey Greene, professeur d’informatique biomédicale, campus médical Anschutz de l’Université du Colorado

La technologie change la nature du travail, et le travail intellectuel n’est pas différent. Les deux dernières décennies ont vu la biologie et la médecine se transformer en faisant progresser rapidement la caractérisation moléculaire, comme le séquençage rapide et peu coûteux de l’ADN, et la numérisation de la médecine sous la forme d’applications, de télémédecine et d’analyse de données.

Certaines étapes de la technologie semblent plus importantes que d’autres. Yahoo a déployé des conservateurs humains pour indexer le contenu émergent à l’aube du World Wide Web. L’avènement d’algorithmes qui utilisaient des informations intégrées dans les modèles de liens du Web pour hiérarchiser les résultats a radicalement modifié le paysage de la recherche, transformant la façon dont les gens recueillent des informations aujourd’hui.

La sortie de ChatGPT d’OpenAI indique un autre bond en avant. ChatGPT intègre un grand modèle de langage à la pointe de la technologie, adapté au chat, dans une interface hautement utilisable. Il met une décennie des progrès rapides de l’intelligence artificielle à portée de main. Cet outil peut écrire des lettres d’accompagnement passables et instruire les utilisateurs sur résoudre les problèmes courants dans les styles de langue sélectionnés par l’utilisateur.

Tout comme les compétences pour trouver des informations sur Internet ont changé avec l’avènement de Google, les compétences nécessaires pour tirer le meilleur résultat des modèles de langage se concentreront sur la création d’invites et de modèles d’invite qui produisent les résultats souhaités.

Pour l’exemple de lettre de motivation, plusieurs invites sont possibles. “Rédiger une lettre de motivation pour un poste” produirait un résultat plus générique que “Rédiger une lettre de motivation pour un poste de spécialiste de la saisie de données”. L’utilisateur peut créer des invites encore plus spécifiques en collant des parties de la description du poste, du CV et des instructions spécifiques – par exemple, “mettre en évidence l’attention portée aux détails”.

Comme pour de nombreuses avancées technologiques, la façon dont les gens interagissent avec le monde changera à l’ère des modèles d’IA largement accessibles. La question est de savoir si la société profitera de ce moment pour faire progresser l’équité ou exacerber les disparités.

Lynne Parker, vice-chancelière associée, Université du Tennessee; Casey Greene, professeur d’informatique biomédicale, Campus médical d’Anschutz de l’Université du Colorado; Daniel Acuña, professeur agrégé d’informatique, professeur affilié de sciences de l’information, Université du Colorado à Boulder; Kentaro Toyama, professeur d’information communautaire, Université du Michiganet Mark Finlayson, professeur agrégé d’informatique, Université internationale de Floride