Les neuroscientifiques découvrent que le fonctionnement interne des modèles de prédiction du mot suivant ressemble à celui des centres de traitement du langage dans le cerveau.

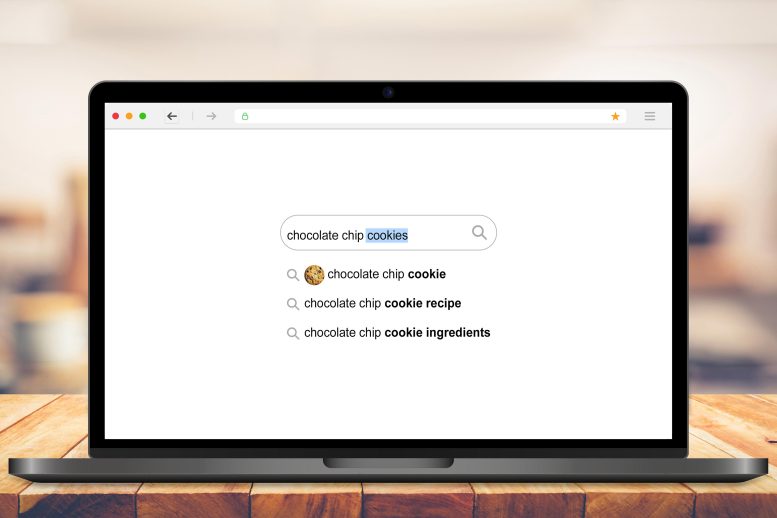

Au cours des dernières années, les modèles de langage d’intelligence artificielle sont devenus très bons pour certaines tâches. Plus particulièrement, ils excellent à prédire le mot suivant dans une chaîne de texte ; cette technologie aide les moteurs de recherche et les applications de SMS à prédire le prochain mot que vous allez taper.

La génération la plus récente de modèles de langage prédictifs semble également apprendre quelque chose sur le sens sous-jacent du langage. Ces modèles peuvent non seulement prédire le mot qui vient ensuite, mais également effectuer des tâches qui semblent nécessiter un certain degré de compréhension authentique, telles que la réponse à des questions, la synthèse de documents et la conclusion d’une histoire.

De tels modèles ont été conçus pour optimiser les performances pour la fonction spécifique de prédiction de texte, sans tenter d’imiter quoi que ce soit sur la façon dont le cerveau humain effectue cette tâche ou comprend le langage. Mais une nouvelle étude de AVEC les neuroscientifiques suggèrent que la fonction sous-jacente de ces modèles ressemble à la fonction des centres de traitement du langage dans le cerveau humain.

: Les neuroscientifiques du MIT découvrent que le fonctionnement interne des modèles de prédiction du mot suivant ressemble à celui des centres de traitement du langage dans le cerveau. Crédit : MIT

Les modèles informatiques qui fonctionnent bien sur d’autres types de tâches langagières ne montrent pas cette similitude avec le cerveau humain, offrant la preuve que le cerveau humain peut utiliser la prédiction du mot suivant pour piloter le traitement du langage.

« Plus le modèle est efficace pour prédire le mot suivant, plus il correspond au cerveau humain », déclare Nancy Kanwisher, professeure Walter A. Rosenblith de neurosciences cognitives, membre de l’Institut McGovern pour la recherche sur le cerveau et du Centre pour le cerveau du MIT, Esprits et machines (CBMM) et auteur de la nouvelle étude. “C’est incroyable que les modèles s’adaptent si bien, et cela suggère très indirectement que peut-être ce que le système du langage humain fait est de prédire ce qui va se passer ensuite.”

Joshua Tenenbaum, professeur de sciences cognitives computationnelles au MIT et membre du CBMM et du laboratoire d’intelligence artificielle du MIT (CSAIL); et Evelina Fedorenko, professeure agrégée de développement de carrière Frederick A. et Carole J. Middleton en neurosciences et membre de l’Institut McGovern, sont les auteurs principaux de l’étude, qui paraît cette semaine dans le Actes de l’Académie nationale des sciences. Martin Schrimpf, un étudiant diplômé du MIT qui travaille au CBMM, est le premier auteur de l’article.

Faire des prédictions

Les nouveaux modèles de prédiction du mot suivant très performants appartiennent à une classe de modèles appelés réseaux de neurones profonds. Ces réseaux contiennent des « nœuds » de calcul qui forment des connexions de force variable et des couches qui transmettent des informations entre elles de manière prescrite.

Au cours de la dernière décennie, les scientifiques ont utilisé des réseaux de neurones profonds pour créer des modèles de vision capables de reconnaître des objets aussi bien que le cerveau des primates. Des recherches au MIT ont également montré que la fonction sous-jacente des modèles de reconnaissance d’objets visuels correspond à l’organisation du cortex visuel des primates, même si ces modèles informatiques n’ont pas été spécifiquement conçus pour imiter le cerveau.

Dans la nouvelle étude, l’équipe du MIT a utilisé une approche similaire pour comparer les centres de traitement du langage dans le cerveau humain avec des modèles de traitement du langage. Les chercheurs ont analysé 43 modèles de langage différents, dont plusieurs optimisés pour la prédiction du mot suivant. Ceux-ci incluent un modèle appelé GPT-3 (Generative Pre-trained Transformer 3), qui, à la suite d’une invite, peut générer un texte similaire à ce qu’un humain produirait. D’autres modèles ont été conçus pour effectuer différentes tâches linguistiques, telles que remplir un blanc dans une phrase.

Comme chaque modèle était présenté avec une chaîne de mots, les chercheurs ont mesuré l’activité des nœuds qui composent le réseau. Ils ont ensuite comparé ces schémas à l’activité du cerveau humain, mesurée chez des sujets effectuant trois tâches langagières : écouter des histoires, lire des phrases une à une et lire des phrases dans lesquelles un mot est révélé à la fois. Ces ensembles de données humaines comprenaient des données de résonance magnétique fonctionnelle (IRMf) et des mesures électrocorticographiques intracrâniennes prises chez des personnes subissant une chirurgie cérébrale pour l’épilepsie.

Ils ont découvert que les modèles de prédiction du mot suivant les plus performants avaient des schémas d’activité très proches de ceux observés dans le cerveau humain. L’activité dans ces mêmes modèles était également fortement corrélée avec des mesures du comportement humain telles que la vitesse à laquelle les gens étaient capables de lire le texte.

«Nous avons constaté que les modèles qui prédisent bien les réponses neuronales ont également tendance à mieux prédire les réponses du comportement humain, sous la forme de temps de lecture. Et puis les deux sont expliqués par les performances du modèle sur la prédiction du mot suivant. Ce triangle relie vraiment tout ensemble », explique Schrimpf.

« Un élément clé de ce travail est que le traitement du langage est un problème très limité : les meilleures solutions que les ingénieurs en IA ont créées finissent par être similaires, comme le montre cet article, aux solutions trouvées par le processus évolutif qui a créé le cerveau humain. . Étant donné que le réseau d’IA n’a pas cherché à imiter directement le cerveau – mais finit par ressembler à un cerveau – cela suggère que, dans un sens, une sorte d’évolution convergente s’est produite entre l’IA et la nature », explique Daniel Yamins, un assistant. professeur de psychologie et d’informatique à l’Université de Stanford, qui n’a pas participé à l’étude.

Changeur de jeu

L’une des principales caractéristiques de calcul des modèles prédictifs tels que GPT-3 est un élément connu sous le nom de transformateur prédictif unidirectionnel direct. Ce type de transformateur est capable de faire des prédictions sur ce qui va suivre, sur la base des séquences précédentes. Une caractéristique importante de ce transformateur est qu’il peut faire des prédictions basées sur un contexte antérieur très long (des centaines de mots), pas seulement les derniers mots.

Les scientifiques n’ont trouvé aucun circuit cérébral ou mécanisme d’apprentissage correspondant à ce type de traitement, explique Tenenbaum. Cependant, les nouvelles découvertes sont cohérentes avec les hypothèses qui ont été précédemment proposées selon lesquelles la prédiction est l’une des fonctions clés du traitement du langage, dit-il.

« L’un des défis du traitement du langage est son aspect en temps réel », dit-il. « Le langage entre en jeu, et vous devez le suivre et être capable de lui donner un sens en temps réel. »

Les chercheurs prévoient maintenant de créer des variantes de ces modèles de traitement du langage pour voir comment de petits changements dans leur architecture affectent leurs performances et leur capacité à s’adapter aux données neuronales humaines.

“Pour moi, ce résultat a changé la donne”, a déclaré Fedorenko. « Cela transforme totalement mon programme de recherche, car je n’aurais pas prédit que de mon vivant nous arriverions à ces modèles informatiques explicites qui capturent suffisamment le cerveau pour que nous puissions réellement les exploiter pour comprendre comment le cerveau fonctionne. »

Les chercheurs prévoient également d’essayer de combiner ces modèles de langage hautement performants avec certains modèles informatiques que le laboratoire de Tenenbaum a déjà développés qui peuvent effectuer d’autres types de tâches telles que la construction de représentations perceptives du monde physique.

“Si nous sommes capables de comprendre ce que font ces modèles de langage et comment ils peuvent se connecter à des modèles qui font des choses qui ressemblent plus à la perception et à la pensée, alors cela peut nous donner des modèles plus intégratifs de la façon dont les choses fonctionnent dans le cerveau”, explique Tenenbaum. . “Cela pourrait nous amener vers de meilleurs modèles d’intelligence artificielle, ainsi que nous donner de meilleurs modèles sur le fonctionnement d’une plus grande partie du cerveau et sur la façon dont l’intelligence générale émerge, que nous n’en avons eu par le passé.”

Référence: Actes de l’Académie nationale des sciences.

La recherche a été financée par une bourse Takeda; la bourse du MIT Shoemaker ; la Semiconductor Research Corporation; les consortiums du MIT Media Lab ; la bourse Singleton du MIT ; la bourse présidentielle d’études supérieures du MIT ; la bourse des Amis de l’Institut McGovern; le MIT Center for Brains, Minds, and Machines, par le biais de la National Science Foundation ; les instituts nationaux de la santé ; le département des sciences du cerveau et des sciences cognitives du MIT ; et l’Institut McGovern.

Les autres auteurs de l’article sont Idan Blank PhD ’16 et les étudiants diplômés Greta Tuckute, Carina Kauf et Eghbal Hosseini.