Personne ne veut être faussement accusé de dire ou de faire quelque chose qui détruira sa réputation. Encore plus cauchemardesque est un scénario où, malgré son innocence, les “preuves” fabriquées contre une personne sont si convaincantes qu’elles sont incapables de se sauver. Pourtant, grâce à un type d’intelligence artificielle (IA) en évolution rapide connu sous le nom de technologie “deepfake”, notre société du futur proche en sera une où tout le monde risque fort de voir exactement ce cauchemar devenir réalité.

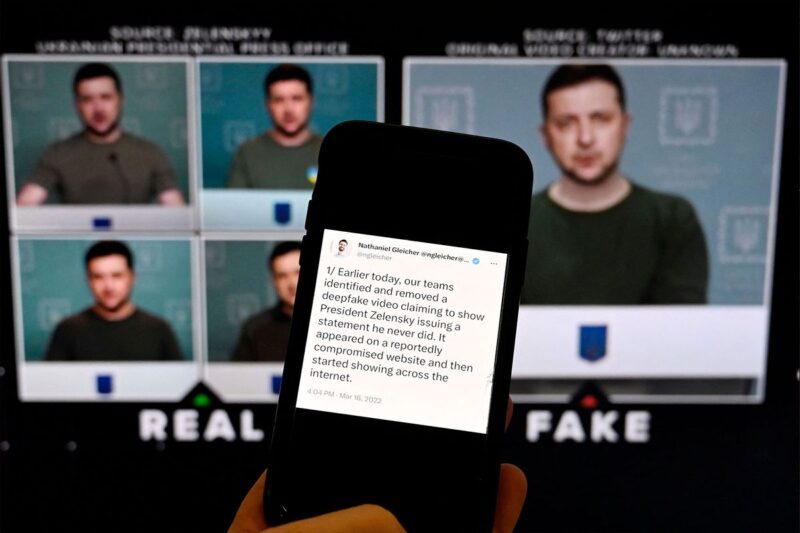

Les deepfakes – ou des vidéos qui ont été modifiées pour donner l’impression que le visage ou le corps d’une personne fait quelque chose qu’il n’a pas fait en fait – sont de plus en plus utilisés pour diffuser de fausses informations et salir leurs cibles. Les dirigeants politiques, religieux et commerciaux expriment déjà leur inquiétude face à la propagation virale des deepfakes qui ont calomnié des personnalités comme l’ancien président américain Donald Trump, le pape François et le PDG de Twitter, Elon Musk. Peut-être le plus inquiétant, un deepfake du président ukrainien Volodomyr Zelenskyy a tenté de duper les Ukrainiens en leur faisant croire que leur armée s’était rendue à la Russie.

Pourtant, les deepfakes ne sont plus si sophistiqués sur le plan technologique qu’ils nécessitent les efforts des agences de renseignement ou des artistes numériques hollywoodiens pour être produits. En effet, les outils dont on a besoin pour créer un deepfake sont si faciles à apprendre que même une personne légèrement calée en informatique peut en produire un relativement convaincant en utilisant des outils prêts à l’emploi. Cela signifie que même les citoyens ordinaires peuvent aussi être les sujets de la malveillance des deepfakers, comme je l’ai appris à mes dépens le 28 février lorsque le dessinateur “Dilbert” Scott Adams a tweeté un deepfake anonyme de moi.

“Un exemple particulièrement troublant d’utilisation malveillante des deepfakes est la pornographie de vengeance.”

Bien que Twitter ait finalement supprimé le deepfake, de nombreuses personnes qui l’ont vu avant que cela ne se produise m’ont dit qu’ils n’avaient aucune idée qu’il avait été modifié. Même certains de mes amis les plus proches ont d’abord pensé que la vidéo était authentique. La vidéo contenait des images de mon visage et de ma voix qui avaient été modifiées de manière inquiétante pour me montrer en train de promouvoir la théorie du Grand Remplacement, une théorie du complot antisémite qui soutient que les Juifs ne vivent qu’avec d’autres Juifs tout en visant à détruire la race blanche par l’intégration. Plus de 50 000 abonnés de Scott Adams ont vu le clip avant qu’il ne soit retiré.

Si les tendances actuelles se poursuivent, beaucoup d’autres vivront bientôt des expériences similaires à la mienne.

Comment la technologie deepfake est-elle devenue si accessible et si facile à utiliser qu’elle inaugurerait une nouvelle crise politique et sociale ? Pour répondre à cela, Salon s’est entretenu par e-mail avec le Dr Siwei Lyu, professeur Empire Innovation d’informatique et d’ingénierie à l’Université de Buffalo School of Engineering and Applied Sciences, qui est un expert en deepfakes. Comme l’a expliqué Liu, l’IA utilisée pour créer des deepfakes fonctionne en manipulant d’innombrables images et images vidéo d’une cible donnée.

“Par exemple, si quelqu’un veut créer un deepfake d’une célébrité, il rassemblera des milliers d’images ou de clips vidéo de cette personne sous différents angles, conditions d’éclairage et expressions”, a déclaré Lyu à Salon. Une fois que le deepfaker a ce dont il a besoin, ses données sont introduites dans ce qu’on appelle un réseau neuronal profond, ou un modèle informatique qui a été formé pour reconnaître les caractéristiques clés d’une personne ou d’un objet et les utiliser pour générer une fausse vidéo convaincante. Les réseaux de neurones profonds sont itératifs, ce qui signifie qu’ils continueront d’améliorer leur rendement à mesure qu’ils traitent des quantités croissantes de données.

La manipulation du visage d’une personne est peut-être la plus troublante de toutes les tactiques de deepfake. Lyu a expliqué que si un deepfaker veut “changer de visage” (transposer le visage de sa cible sur celui de quelqu’un d’une vidéo authentique), “cela implique de générer une image réaliste du nouveau visage et de l’aligner avec la position, l’angle et l’angle du visage d’origine. conditions d’éclairage.” En revanche, si un deepfaker souhaite simplement mettre des mots dans la bouche de sa cible – connu sous le nom de synchronisation labiale – le modèle modifiera les mouvements de la bouche de la personne et manipulera sa voix pour former littéralement les mots que la partie malveillante souhaite mettre dans la bouche de sa victime. .

“La vidéo résultante peut nécessiter des ajustements supplémentaires pour garantir que la vidéo finale semble transparente et réaliste”, a conclu Lyu. “Cela peut impliquer de mélanger les bords des zones manipulées avec le métrage d’origine ou de corriger toute incohérence d’éclairage et de couleur.”

“L’état actuel de l’IA générative signifie qu’il y a souvent des problèmes avec les mains, une peau cireuse, des ombres irréalistes, des reflets oculaires qui n’ont pas de sens dans le monde réel.”

Sam Gregory – le directeur exécutif de l’organisation à but non lucratif de défense des droits de l’homme WITNESS, et qui a dirigé pendant cinq ans une initiative mondiale appelée “Prepare, Don’t Panic” qui se concentre sur la préparation à la montée des deepfakes – a expliqué pourquoi la technologie deepfake a devenu plus facile et plus accessible ces dernières années.

“L’une des avancées de ces dernières années en matière d’audio et de création de courtes vidéos à partir d’images a été de nécessiter de moins en moins d’images, voire une seule image ou un seul court extrait audio, pour créer une simulation d’un individu particulier”, a déclaré Gregory. Salon par messagerie directe. Parce que les échanges de visages à part entière nécessitent des outils connus sous le nom de “Generative Adversarial Networks” (GAN) qui utilisent deux réseaux de neurones concurrents pour perfectionner le produit final, “les deepfakes complets dans des scènes réelles restent difficiles à faire vraiment bien”. Ceci, cependant, n’est pas vrai pour les deepfakes moins ambitieux, tels que ceux qui reposent simplement sur l’audio ou sur l’animation d’une photographie fixe.

“Les outils de doublage et de marionnettes à synchronisation labiale sont parmi les plus accessibles – l’idée étant que vous pouvez faire correspondre les lèvres de quelqu’un à une piste audio, ou vous pouvez animer un avatar d’apparence humaine pour qu’il parle”, a expliqué Gregory. “Les progrès récents dans l’espace technologique plus large de l'” IA générative ” incluent des outils de ” texte à image ” comme Dall-E ou Midjourney. Ceux-ci reposent à nouveau sur la formation d’un algorithme sur des quantités massives de données d’image étiquetées pour lui permettre ensuite de créer entièrement nouveau images.” Bien qu’ils ne soient pas aussi sophistiqués que GAN, ils peuvent toujours faire en sorte que les consommateurs sans méfiance croient aux images manipulées.

“J’imagine qu’avec le temps, ces plates-formes obligeront les utilisateurs à reconnaître qu’ils ont l’utilisation légale de la vidéo sous-jacente qu’ils manipulent.”

Tout cela donne l’impression que nous avons ouvert la boîte de Pandore. Pourtant, la situation n’est pas entièrement désespérée. Pour les personnes qui souhaitent repérer et dénoncer la désinformation, il existe des méthodes pour identifier les deepfakes.

“Il y a plusieurs choses que les consommateurs d’informations ordinaires peuvent faire”, a déclaré Shawn DuBravac, expert en médias synthétiques, économiste en chef et directeur principal de la recherche à la Consumer Electronics Association et auteur du livre à succès du New York Times “Digital Destiny : How the La nouvelle ère des données transformera notre façon de travailler, de vivre et de communiquer.” Bien qu’il ait ajouté une mise en garde – la plupart des gens ne sont pas en mesure de détecter de manière fiable tout deepfake raisonnablement compétent – DuBravac a exhorté les consommateurs de nouvelles à néanmoins exercer des compétences de discernement de base.

“Vérifiez la source”, a déclaré DuBravac à Salon. Les consommateurs d’actualités devraient essayer de vérifier les vidéos – soit en les retraçant jusqu’à leur origine, soit en confirmant leur authenticité avec plusieurs sources – au lieu de simplement croire une vidéo convaincante parce qu’elle correspond à leurs croyances préexistantes.

En outre, les consommateurs peuvent essayer d’analyser une vidéo donnée “pour détecter des incohérences ou des irrégularités dans le format du support ou dans le contenu réel. Cela peut inclure l’examen du contexte de l’information transmise”. Par exemple, dans le cas du deepfake qui me visait, le créateur anonyme m’a fait désigner un lieu de culte juif comme une “église”, même si les juifs adorent dans des bâtiments appelés synagogues. De même, le créateur anonyme a laissé des indices révélant sa fausseté ; ce n’est pas rare chez ceux qui fabriquent et diffusent des deepfakes, mais veulent rester du bon côté de la loi. Le créateur anonyme a inclus un filigrane D-ID faiblement visible caché dans le coin “qui l’identifie en provenance d’une plate-forme de création vidéo générée par l’IA”.

“J’imagine qu’avec le temps, ces plates-formes obligeront les utilisateurs à reconnaître qu’ils ont l’utilisation légale de la vidéo sous-jacente qu’ils manipulent”, a spéculé DuBravac. Même sans ce genre d’exigences, cependant, les deepfakes peuvent toujours inclure des preuves visuelles de leur nature fabriquée. Par exemple, DuBravac a noté que souvent dans un deepfake “les mouvements de la bouche ne sont pas parfaitement alignés avec les mots prononcés”. De même, la technologie aura souvent du mal à faire la distinction entre la tête et le corps d’une cible et l’arrière-plan, ou en général ne semble pas se fondre correctement avec son environnement. Ces choses sont difficiles à repérer pour les utilisateurs non formés – la recherche révèle que c’est notoirement difficile – mais ce n’est pas tout à fait impossible.

“Certaines activités, telles que les deepfakes réalistes en plein visage dans des scènes complexes, sont encore difficiles à bien faire – et il est peu probable qu’elles soient utilisées pour des vidéos trompeuses, par exemple dans la politique locale.”

“Si vous pensez aux images générées par l’IA, l’état actuel de l’IA générative signifie qu’il y a souvent des problèmes avec les mains (par exemple, une distorsion), une peau cireuse, des ombres irréalistes, des reflets oculaires qui n’ont pas de sens dans le monde réel et des objets qui semblent se fondre dans d’autres objets en dehors des lois de la physique”, a déclaré Gregory à Salon. “Les outils d’IA ne réussissent pas non plus à créer directement du texte dans une image et, par exemple, ne captureront pas nécessairement le bon logo ou la bonne étiquette pour un agent des forces de l’ordre.” Dans le même temps, Gregory a averti que “nous ne devrions pas nous fier à ces tendances ; ces systèmes s’améliorent rapidement, s’améliorent de plus en plus et visent à obtenir un aspect plus réaliste. Nous savons par expérience que ces “indices” disparaissent rapidement. – par exemple, les gens pensaient que les deepfakes ne clignaient pas des yeux, et maintenant ils le font.” Par conséquent, les journalistes doivent se tenir au courant de l’évolution de la technologie deepfake afin que, lorsque ces failles sont corrigées, ils puissent être au courant d’autres failles qui les alerteront et alerteront leur public en cas de contenu frauduleux.

“Par exemple, il est utile de savoir ce qui est de plus en plus facile à faire en ce moment – simuler de l’audio ou créer rapidement des images réalistes – alors que certaines activités, telles que des deepfakes réalistes sur tout le visage dans des scènes complexes, sont encore difficiles à bien faire et sont peu probables. être utilisé pour des vidéos trompeuses dans, par exemple, la politique locale », a déclaré Gregory à Salon. “Cela changera avec le temps, mais cela fait partie du rôle des médias de tenir les gens informés.”

Étant donné que les outils de détection en ligne des deepfakes sont notoirement peu fiables, il incombe aux journalistes de faire le travail de fond.

“Plus important encore, le fardeau et le blâme ne devraient pas incomber aux téléspectateurs et aux individus pour détecter des contrefaçons de plus en plus sophistiquées et indiscernables à l’œil”, a déclaré Gregory. “Nous ne pouvons pas simplement dire aux gens de regarder les pixels et les détails de chaque image et vidéo qu’ils rencontrent en ligne. Nous avons entendu à plusieurs reprises dans le travail et les recherches que nous avons menés à l’échelle mondiale que nous devons responsabiliser les entreprises qui développent des technologies. , les plateformes et les distributeurs, qui devraient filigraner le contenu et développer une technologie de provenance et de détection qui peut nous aider à voir que les images ont été synthétisées, manipulées et partagées et garantir que ces traces restent avec les images lorsqu’elles circulent.”

Cependant, toutes ces mesures prendront du temps et, dans l’intervalle, la technologie deepfake continuera d’évoluer. Cela signifie que des scénarios inquiétants impliquant des deepfakes continueront de se produire, y compris ceux qui semblent dans le monde entier comme des cauchemars devenus réalité.

“Un exemple particulièrement troublant d’utilisation malveillante de deepfakes dont j’ai l’expérience est la pornographie de vengeance”, a déclaré Lyu à Salon, faisant référence à la pratique consistant à créer “un contenu explicite non consensuel, ciblant souvent l’ex-conjoint ou l’ex-partenaire, et les victimes sont généralement des femmes.” Dans ces images, le visage de la victime est échangé avec le visage d’un acteur dans une vidéo pornographique, créant des vidéos ou des images réalistes qui donnent l’impression que la personne se livre à des actes explicites. “Ces deepfakes sont souvent partagés en ligne à l’insu de la victime ou sans son consentement, provoquant une détresse émotionnelle importante, des atteintes à la réputation et même des conséquences juridiques”, a ajouté Lyu.