Peu de temps après la fuite de rumeurs sur l’inculpation imminente de l’ancien président Donald Trump, des images prétendant montrer son arrestation sont apparues en ligne. Ces images ressemblaient à des photos d’actualité, mais elles étaient fausses. Ils ont été créés par un système d’intelligence artificielle générative.

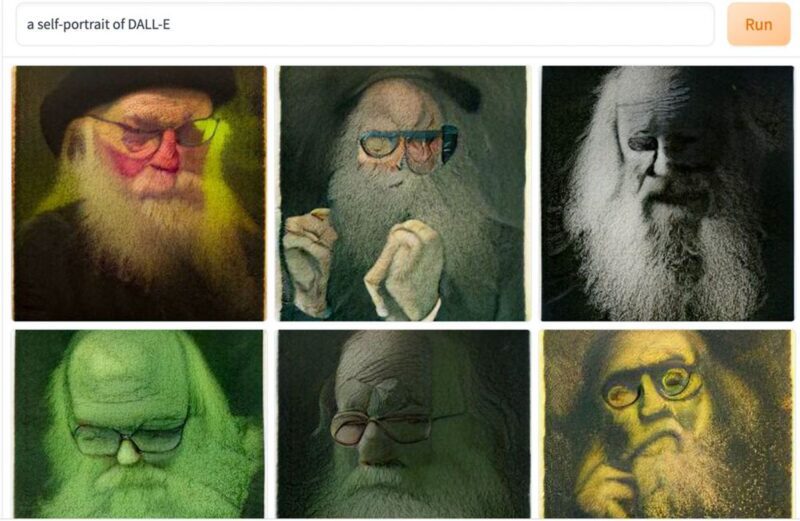

L’IA générative, sous la forme de générateurs d’images comme DALL-E, Midjourney et Stable Diffusion, et de générateurs de texte comme Bard, ChatGPT, Chinchilla et LLaMA, a explosé dans la sphère publique. En combinant des algorithmes d’apprentissage automatique intelligents avec des milliards de contenus générés par l’homme, ces systèmes peuvent faire n’importe quoi, de créer une image étrangement réaliste à partir d’une légende, synthétiser un discours dans la voix du président Joe Biden, remplacer la ressemblance d’une personne par une autre dans une vidéo , ou rédigez un éditorial cohérent de 800 mots à partir d’une invite de titre.

Même à ses débuts, l’IA générative est capable de créer un contenu très réaliste. Ma collègue Sophie Nightingale et moi avons constaté que la personne moyenne est incapable de distinguer de manière fiable une image d’une personne réelle d’une personne générée par l’IA. Bien que l’audio et la vidéo ne soient pas encore complètement passés par la vallée de l’étrange – images ou modèles de personnes troublants parce qu’ils sont proches mais pas tout à fait réalistes – ils le seront probablement bientôt. Lorsque cela se produira, et c’est presque garanti, il deviendra de plus en plus facile de déformer la réalité.

Dans ce nouveau monde, ce sera un jeu d’enfant de générer une vidéo d’un PDG disant que les bénéfices de son entreprise sont en baisse de 20 %, ce qui pourrait entraîner des milliards de pertes de parts de marché, ou de générer une vidéo d’un leader mondial menaçant une action militaire, qui pourrait déclencher une crise géopolitique, ou d’insérer l’image de n’importe qui dans une vidéo sexuellement explicite.

La technologie permettant de créer de fausses vidéos de personnes réelles devient de plus en plus disponible.

Les progrès de l’IA générative signifieront bientôt que des contenus factices mais visuellement convaincants proliféreront en ligne, conduisant à un écosystème d’informations encore plus désordonné. Une conséquence secondaire est que les détracteurs pourront facilement rejeter comme fausses preuves vidéo réelles de tout, de la violence policière et des violations des droits de l’homme à un leader mondial brûlant des documents top secrets.

Alors que la société regarde le baril de ce qui n’est presque certainement que le début de ces avancées dans l’IA générative, il existe des interventions raisonnables et technologiquement réalisables qui peuvent être utilisées pour aider à atténuer ces abus. En tant qu’informaticien spécialisé dans l’imagerie médico-légale, je pense qu’une méthode clé est le filigrane.

Filigranes

Il existe une longue histoire de marquage de documents et d’autres objets pour prouver leur authenticité, indiquer la propriété et la contrefaçon. Aujourd’hui, Getty Images, une archive d’images massive, ajoute un filigrane visible à toutes les images numériques de son catalogue. Cela permet aux clients de parcourir librement les images tout en protégeant les actifs de Getty.

Des filigranes numériques imperceptibles sont également utilisés pour la gestion des droits numériques. Un filigrane peut être ajouté à une image numérique, par exemple, en ajustant tous les 10 pixels de l’image afin que sa couleur (généralement un nombre compris entre 0 et 255) soit de valeur paire. Parce que ce réglage de pixel est si mineur, le filigrane est imperceptible. Et, comme il est peu probable que ce motif périodique se produise naturellement et qu’il peut être facilement vérifié, il peut être utilisé pour vérifier la provenance d’une image.

Même les images à résolution moyenne contiennent des millions de pixels, ce qui signifie que des informations supplémentaires peuvent être intégrées dans le filigrane, y compris un identifiant unique qui encode le logiciel de génération et un ID utilisateur unique. Ce même type de filigrane imperceptible peut être appliqué à l’audio et à la vidéo.

Le filigrane idéal est celui qui est imperceptible et également résistant aux manipulations simples comme le recadrage, le redimensionnement, l’ajustement des couleurs et la conversion des formats numériques. Bien que l’exemple de filigrane de couleur de pixel ne soit pas résilient car les valeurs de couleur peuvent être modifiées, de nombreuses stratégies de filigrane ont été proposées qui sont robustes – mais pas insensibles – aux tentatives de les supprimer.

Filigrane et IA

Ces filigranes peuvent être intégrés aux systèmes d’IA générative en filigranant toutes les données de formation, après quoi le contenu généré contiendra le même filigrane. Ce filigrane intégré est attrayant car il signifie que les outils d’IA génératifs peuvent être open source – comme le générateur d’images Stable Diffusion l’est – sans craindre qu’un processus de filigrane puisse être supprimé du logiciel du générateur d’images. Stable Diffusion a une fonction de filigrane, mais comme il est open source, n’importe qui peut simplement supprimer cette partie du code.

OpenAI expérimente un système pour filigraner les créations de ChatGPT. Bien sûr, les caractères d’un paragraphe ne peuvent pas être modifiés comme une valeur de pixel, de sorte que le filigrane de texte prend une forme différente.

L’IA générative basée sur le texte est basée sur la production du prochain mot le plus raisonnable dans une phrase. Par exemple, en commençant par le fragment de phrase « un système d’IA peut… », ChatGPT prédira que le mot suivant devrait être « apprendre », « prédire » ou « comprendre ». A chacun de ces mots est associée une probabilité correspondant à la probabilité que chaque mot apparaisse ensuite dans la phrase. ChatGPT a appris ces probabilités à partir du grand corps de texte sur lequel il a été formé.

Le texte généré peut être filigrané en étiquetant secrètement un sous-ensemble de mots, puis en biaisant la sélection d’un mot pour qu’il soit un mot étiqueté synonyme. Par exemple, le mot étiqueté “comprendre” peut être utilisé à la place de “comprendre”. En biaisant périodiquement la sélection de mots de cette manière, un corps de texte est filigrané sur la base d’une distribution particulière de mots étiquetés. Cette approche ne fonctionnera pas pour les tweets courts, mais est généralement efficace avec un texte de 800 mots ou plus en fonction des détails spécifiques du filigrane.

Les systèmes d’IA générative peuvent, et je pense qu’ils devraient, filigraner tout leur contenu, permettant une identification en aval plus facile et, si nécessaire, une intervention. Si l’industrie ne le fait pas volontairement, les législateurs pourraient adopter une réglementation pour faire appliquer cette règle. Les personnes peu scrupuleuses ne respecteront bien sûr pas ces normes. Mais si les principaux contrôleurs d’accès en ligne – les magasins d’applications Apple et Google, Amazon, Google, les services cloud de Microsoft et GitHub – appliquent ces règles en interdisant les logiciels non conformes, les dommages seront considérablement réduits.

Signer un contenu authentique

En abordant le problème de l’autre côté, une approche similaire pourrait être adoptée pour authentifier les enregistrements audiovisuels originaux au point de capture. Une application de caméra spécialisée pourrait signer de manière cryptographique le contenu enregistré au fur et à mesure de son enregistrement. Il n’y a aucun moyen de falsifier cette signature sans laisser de trace de la tentative. La signature est ensuite stockée sur une liste centralisée de signatures de confiance.

Bien qu’il ne s’applique pas au texte, le contenu audiovisuel peut alors être vérifié comme étant généré par l’homme. La Coalition for Content Provenance and Authentication (C2PA), un effort collaboratif visant à créer une norme d’authentification des médias, a récemment publié une spécification ouverte pour prendre en charge cette approche. Avec des institutions majeures telles qu’Adobe, Microsoft, Intel, la BBC et bien d’autres qui se joignent à cet effort, le C2PA est bien placé pour produire une technologie d’authentification efficace et largement déployée.

La signature et le filigranage combinés du contenu généré par l’homme et par l’IA n’empêcheront pas toutes les formes d’abus, mais fourniront une certaine protection. Toutes les garanties devront être continuellement adaptées et affinées à mesure que les adversaires trouvent de nouvelles façons de militariser les dernières technologies.

De la même manière que la société mène une bataille de plusieurs décennies contre d’autres cybermenaces telles que le spam, les logiciels malveillants et le phishing, nous devons nous préparer à une bataille tout aussi longue pour nous défendre contre diverses formes d’abus perpétrés à l’aide de l’IA générative.

Hany Farid, professeur d’informatique, Université de Californie, Berkeley