Créer une IA à l’image de l’humain ne se limite pas à imiter le comportement humain – la technologie doit également être capable de traiter l’information, ou de « penser », comme les humains également si l’on veut s’y fier pleinement.

Nouvelle recherche, publiée dans la revue Motifs et dirigé par le Université de GlasgowL’École de psychologie et de neurosciences de , utilise la modélisation 3D pour analyser la façon dont les réseaux de neurones profonds – qui font partie de la famille plus large de l’apprentissage automatique – traitent les informations, afin de visualiser comment leur traitement des informations correspond à celui des humains.

On espère que ce nouveau travail ouvrira la voie à la création d’une technologie d’IA plus fiable qui traitera les informations comme les humains et fera des erreurs que nous pouvons comprendre et prévoir.

L’un des défis auxquels le développement de l’IA est encore confronté est de mieux comprendre le processus de la pensée machine et de savoir s’il correspond à la façon dont les humains traitent l’information, afin de garantir précision. Les réseaux de neurones profonds sont souvent présentés comme le meilleur modèle actuel de comportement décisionnel humain, atteignant ou même dépassant les performances humaines dans certaines tâches. Cependant, même des tâches de discrimination visuelle trompeusement simples peuvent révéler des incohérences et des erreurs claires des modèles d’IA, par rapport aux humains.

Actuellement, la technologie Deep Neural Network est utilisée dans des applications telles que la reconnaissance faciale, et bien qu’elle soit très efficace dans ces domaines, les scientifiques ne comprennent toujours pas pleinement comment ces réseaux traitent les informations, et donc quand des erreurs peuvent se produire.

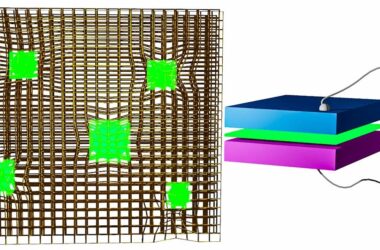

Dans cette nouvelle étude, l’équipe de recherche a abordé ce problème en modélisant le stimulus visuel que le Deep Neural Network a reçu, en le transformant de plusieurs manières afin qu’ils puissent démontrer une similitude de reconnaissance, via le traitement d’informations similaires entre les humains et le modèle d’IA.

Le professeur Philippe Schyns, auteur principal de l’étude et directeur de l’Institut des neurosciences et de la technologie de l’Université de Glasgow, a déclaré : « Lors de la création de modèles d’IA qui se comportent « comme » des humains, par exemple pour reconnaître le visage d’une personne chaque fois qu’elle le voit comme un être humain ferait, nous devons nous assurer que le modèle d’IA utilise les mêmes informations du visage qu’un autre humain ferait pour le reconnaître. Si l’IA ne fait pas cela, nous pourrions avoir l’illusion que le système fonctionne exactement comme les humains, mais ensuite découvrir qu’il se trompe dans des circonstances nouvelles ou non testées.

Les chercheurs ont utilisé une série de visages 3D modifiables et ont demandé aux humains d’évaluer la similitude de ces visages générés aléatoirement avec quatre identités familières. Ils ont ensuite utilisé ces informations pour tester si les réseaux de neurones profonds faisaient les mêmes évaluations pour les mêmes raisons – en testant non seulement si les humains et l’IA prenaient les mêmes décisions, mais aussi si elles étaient basées sur les mêmes informations. Surtout, avec leur approche, les chercheurs peuvent visualiser ces résultats comme les visages 3D qui déterminent le comportement des humains et des réseaux. Par exemple, un réseau qui a correctement classé 2 000 identités était animé par un visage fortement caricatural, montrant qu’il identifiait les visages traitant des informations faciales très différentes de celles des humains.

Les chercheurs espèrent que ce travail ouvrira la voie à une technologie d’IA plus fiable qui se comporte davantage comme les humains et fait moins d’erreurs imprévisibles.

Référence : « Grounding deep neural network prédictions of human catégorisation behavior in Understanding Functional Features : The case of face identity » par Christoph Daube, Tian Xu, Jiayu Zhan, Andrew Webb, Robin AA Ince, Oliver GB Garrod et Philippe G. Schyns, 10 septembre 2021, Motifs.

DOI: 10.1016/j.patter.2021.100348

L’étude a été financée par Wellcome Trust et le Engineering and Physical Sciences Research Council (EPSRC), qui fait partie du UK Research and Innovation.