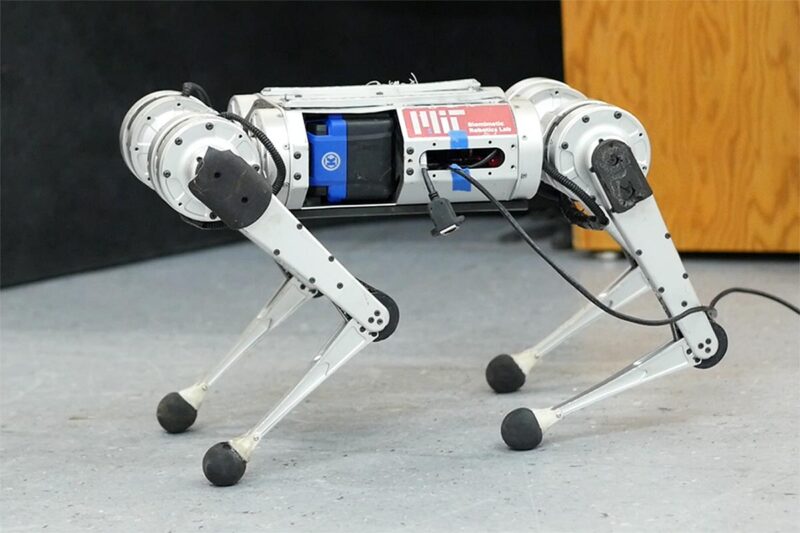

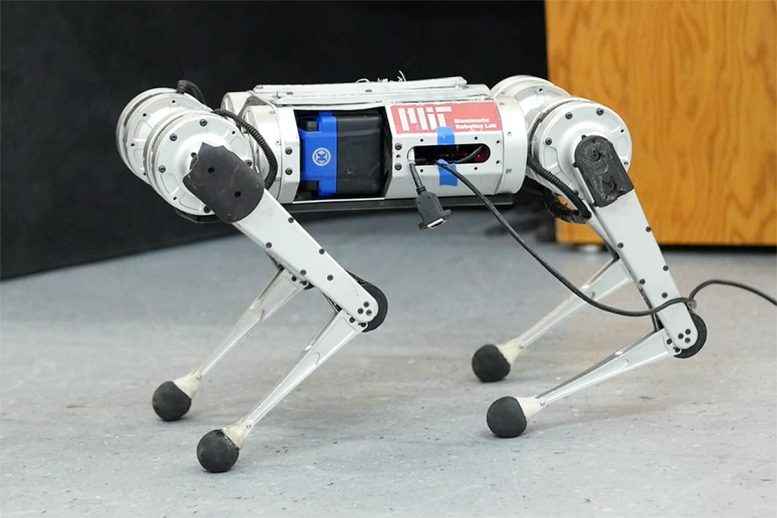

Le mini guépard du MIT, utilisant un système d’apprentissage par renforcement sans modèle, a battu le record de la course la plus rapide enregistrée. Crédit : Photo avec l’aimable autorisation du MIT CSAIL.

Les scientifiques du CSAIL ont mis au point un pipeline d’apprentissage pour le robot à quatre pattes qui apprend à courir entièrement par essais et erreurs en simulation.

Il y a environ 23 ans que l’un des premiers robots à quatre pattes du MIT a été mis au point. animaux robotisés ont trotté sur la scène, défiant les notions classiques de nos amis à quatre pattes en peluche. Depuis lors, une multitude de machines à marcher, à danser et à ouvrir les portes ont imposé leur présence, un mélange élégant de piles, de capteurs, de métal et de moteurs. Parmi les activités cardio, il en est une qui est à la fois aimée et détestée par les humains (selon la personne à qui on la demande) et qui s’est avérée un peu plus difficile pour les robots : apprendre à courir.

Des chercheurs de MIT’s Improbable AI Lab, part of the Computer Science and Artificial Intelligence Laboratory (CSAIL) and directed by MIT Assistant Professor Pulkit Agrawal, as well as the Institute of AI and Fundamental Interactions (IAIFI) have been working on fast-paced strides for a robotic mini cheetah — and their model-free reinforcement learning system broke the record for the fastest run recorded. Here, MIT PhD student Gabriel Margolis and IAIFI postdoc Ge Yang discuss just how fast the cheetah can run.

Q: We’ve seen videos of robots running before. Why is running harder than walking?

A: Achieving fast running requires pushing the hardware to its limits, for example by operating near the maximum torque output of motors. In such conditions, the robot dynamics are hard to analytically model. The robot needs to respond quickly to changes in the environment, such as the moment it encounters ice while running on grass. If the robot is walking, it is moving slowly and the presence of snow is not typically an issue. Imagine if you were walking slowly, but carefully: you can traverse almost any terrain. Today’s robots face an analogous problem. The problem is that moving on all terrains as if you were walking on ice is very inefficient, but is common among today’s robots. Humans run fast on grass and slow down on ice — we adapt. Giving robots a similar capability to adapt requires quick identification of terrain changes and quickly adapting to prevent the robot from falling over. In summary, because it’s impractical to build analytical (human-designed) models of all possible terrains in advance, and the robot’s dynamics become more complex at high-velocities, high-speed running is more challenging than walking.

Le mini guépard du MIT apprend à courir plus vite que jamais, en utilisant un pipeline d’apprentissage entièrement par essais et erreurs en simulation.

Q : Les précédents contrôleurs de course agile pour le MIT Cheetah 3 et le mini guépard, ainsi que pour les robots de Boston Dynamics, sont ” conçus de manière analytique “, en s’appuyant sur des ingénieurs humains pour analyser la physique de la locomotion, formuler des abstractions efficaces et mettre en œuvre une hiérarchie spécialisée de contrôleurs pour que le robot s’équilibre et court. Vous utilisez un “modèle d’apprentissage par l’expérience” pour la course au lieu de la programmer. Pourquoi ?

A : Programmer la façon dont un robot doit agir dans toutes les situations possibles est tout simplement très difficile. Le processus est fastidieux, car si un robot devait échouer sur un terrain particulier, un ingénieur humain devrait identifier la cause de l’échec et adapter manuellement le contrôleur du robot, et ce processus peut demander beaucoup de temps humain. L’apprentissage par essais et erreurs supprime la nécessité pour un humain de spécifier précisément comment le robot doit se comporter dans chaque situation. Cela fonctionnerait si : (1) le robot peut expérimenter une gamme extrêmement large de terrains ; et (2) le robot peut améliorer automatiquement son comportement avec l’expérience.

Grâce aux outils de simulation modernes, notre robot peut accumuler 100 jours d’expérience sur divers terrains en seulement trois heures de temps réel. Nous avons développé une approche par laquelle le comportement du robot s’améliore à partir de l’expérience simulée, et notre approche permet aussi, de manière critique, le déploiement réussi de ces comportements appris dans le monde réel. L’intuition qui sous-tend la raison pour laquelle les compétences de course du robot fonctionnent bien dans le monde réel est la suivante : parmi tous les environnements qu’il voit dans ce simulateur, certains vont enseigner au robot des compétences utiles dans le monde réel. Lorsqu’il opère dans le monde réel, notre contrôleur identifie et exécute les compétences pertinentes en temps réel.

Q : Cette approche peut-elle être mise à l’échelle au-delà du mini guépard ? Qu’est-ce qui vous enthousiasme dans ses applications futures ?

A : Au cœur de la recherche sur l’intelligence artificielle se trouve le compromis entre ce que l’homme doit intégrer (nature) et ce que la machine peut apprendre par elle-même (éducation). Le paradigme traditionnel en robotique est que les humains indiquent au robot la tâche à accomplir et la manière de l’accomplir. Le problème est qu’un tel cadre n’est pas évolutif, car il faudrait un immense effort d’ingénierie humaine pour programmer manuellement un robot capable de fonctionner dans des environnements très divers. Une façon plus pratique de construire un robot avec des compétences diverses est de dire au robot ce qu’il doit faire et de le laisser trouver le comment. Notre système en est un exemple. Dans notre laboratoire, nous avons commencé à appliquer ce paradigme à d’autres systèmes robotiques, notamment à des mains capables de ramasser et de manipuler de nombreux objets différents.

Ce travail a été soutenu par le DARPA Machine Common Sense Program, le MIT Biomimetic Robotics Lab, NAVER LABS, et en partie par le National Science Foundation AI Institute for Artificial Intelligence Fundamental Interactions, United States Air Force-MIT AI Accelerator, et MIT-IBM Watson AI Lab. Les recherches ont été menées par l’Improbable AI Lab.