Un nouveau système de contrôle, démontré en utilisant AVECLe mini guépard robotique de , permet aux robots à quatre pattes de sauter sur un terrain accidenté en temps réel.

Un guépard se précipite à travers un champ vallonné, bondissant sur des lacunes soudaines dans le terrain accidenté. Le mouvement peut sembler sans effort, mais faire bouger un robot de cette façon est une tout autre perspective.

Ces dernières années, les robots à quatre pattes inspirés par le mouvement des guépards et d’autres animaux ont fait de grands pas en avant, mais ils sont toujours à la traîne par rapport à leurs homologues mammifères lorsqu’il s’agit de traverser un paysage avec des changements d’altitude rapides.

« Dans ces contextes, vous devez utiliser la vision afin d’éviter l’échec. Par exemple, il est difficile d’éviter de marcher dans un espace si vous ne pouvez pas le voir. Bien qu’il existe certaines méthodes existantes pour incorporer la vision dans la locomotion des jambes, la plupart d’entre elles ne sont pas vraiment adaptées à une utilisation avec les systèmes robotiques agiles émergents », explique Gabriel Margolis, doctorant au laboratoire de Pulkit Agrawal, professeur en informatique et Laboratoire d’intelligence artificielle (CSAIL) au MIT.

Désormais, Margolis et ses collaborateurs ont développé une système qui améliore la vitesse et l’agilité des robots à pattes alors qu’ils sautent à travers les trous dans le terrain. Le nouveau système de contrôle est divisé en deux parties : une qui traite les entrées en temps réel d’une caméra vidéo montée à l’avant du robot et une autre qui traduit ces informations en instructions sur la façon dont le robot doit bouger son corps. Les chercheurs ont testé leur système sur le mini guépard du MIT, un robot puissant et agile construit dans le laboratoire de Sangbae Kim, professeur de génie mécanique.

Contrairement à d’autres méthodes de contrôle d’un robot à quatre pattes, ce système en deux parties ne nécessite pas de cartographier le terrain à l’avance, de sorte que le robot peut aller n’importe où. À l’avenir, cela pourrait permettre aux robots de foncer dans les bois lors d’une mission d’intervention d’urgence ou de monter un escalier pour livrer des médicaments à une personne âgée enfermée.

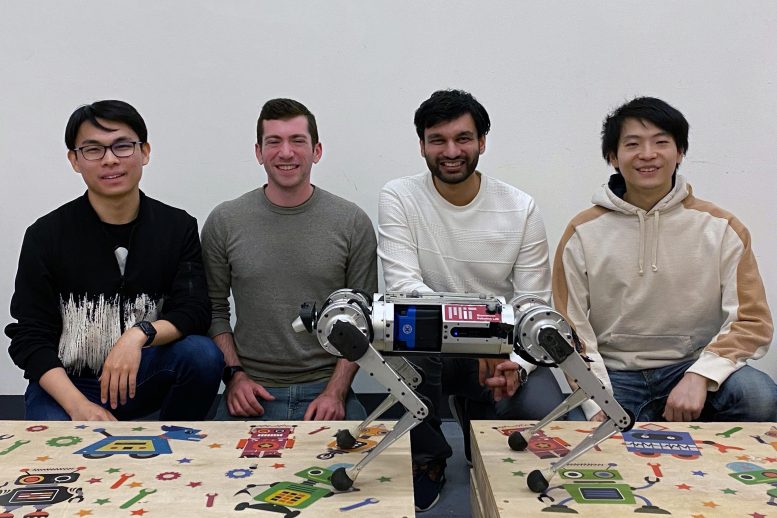

Margolis a écrit l’article avec l’auteur principal Pulkit Agrawal, qui dirige le laboratoire d’IA improbable au MIT et est le professeur adjoint de développement de carrière Steven G. et Renee Finn au département de génie électrique et d’informatique ; le professeur Sangbae Kim du département de génie mécanique du MIT ; et d’autres étudiants diplômés Tao Chen et Xiang Fu au MIT. D’autres co-auteurs incluent Kartik Paigwar, un étudiant diplômé de l’Arizona State University ; et Donghyun Kim, professeur adjoint à l’Université du Massachusetts à Amherst. Les travaux seront présentés le mois prochain lors de la Conférence sur l’apprentissage robotique.

Tout est sous contrôle

L’utilisation de deux contrôleurs distincts travaillant ensemble rend ce système particulièrement innovant.

Un contrôleur est un algorithme qui convertira l’état du robot en un ensemble d’actions à suivre. De nombreux contrôleurs aveugles – ceux qui n’intègrent pas la vision – sont robustes et efficaces mais ne permettent aux robots de marcher que sur un terrain continu.

La vision est une entrée sensorielle si complexe à traiter que ces algorithmes sont incapables de la gérer efficacement. Les systèmes qui intègrent la vision reposent généralement sur une « carte de hauteur » du terrain, qui doit être soit préconstruite, soit générée à la volée, un processus généralement lent et susceptible d’échouer si la carte de hauteur est incorrecte.

De gauche à droite : les doctorants Tao Chen et Gabriel Margolis ; Pulkit Agrawal, professeur adjoint en développement de carrière Steven G. et Renee Finn au Département de génie électrique et d’informatique ; et le doctorant Xiang Fu. Crédit : Photo gracieuseté des chercheurs

Pour développer leur système, les chercheurs ont pris les meilleurs éléments de ces contrôleurs aveugles robustes et les ont combinés avec un module séparé qui gère la vision en temps réel.

La caméra du robot capture des images de profondeur du terrain à venir, qui sont transmises à un contrôleur de haut niveau avec des informations sur l’état du corps du robot (angles articulaires, orientation du corps, etc.). Le contrôleur de haut niveau est un réseau neuronal qui « apprend » par expérience.

Ce réseau de neurones génère une trajectoire cible, que le deuxième contrôleur utilise pour générer des couples pour chacune des 12 articulations du robot. Ce contrôleur de bas niveau n’est pas un réseau de neurones et s’appuie plutôt sur un ensemble d’équations physiques concises qui décrivent le mouvement du robot.

« La hiérarchie, y compris l’utilisation de ce contrôleur de bas niveau, nous permet de contraindre le comportement du robot pour qu’il se comporte mieux. Avec ce contrôleur de bas niveau, nous utilisons des modèles bien spécifiés sur lesquels nous pouvons imposer des contraintes, ce qui n’est généralement pas possible dans un réseau basé sur l’apprentissage », explique Margolis.

Enseigner le réseau

Les chercheurs ont utilisé la méthode d’essais et d’erreurs connue sous le nom d’apprentissage par renforcement pour former le contrôleur de haut niveau. Ils ont effectué des simulations du robot traversant des centaines de terrains discontinus différents et l’ont récompensé pour les traversées réussies.

Au fil du temps, l’algorithme a appris quelles actions maximisaient la récompense.

Ensuite, ils ont construit un terrain physique avec un ensemble de planches de bois et ont mis leur système de contrôle à l’épreuve à l’aide du mini guépard.

« C’était vraiment amusant de travailler avec un robot conçu en interne au MIT par certains de nos collaborateurs. Le mini guépard est une excellente plate-forme car il est modulaire et fabriqué principalement à partir de pièces que vous pouvez commander en ligne, donc si nous voulions une nouvelle batterie ou un nouvel appareil photo, il suffisait simplement de le commander auprès d’un fournisseur régulier et, avec un peu un peu d’aide du laboratoire de Sangbae pour l’installer », explique Margolis.

Estimer l’état du robot s’est avéré être un défi dans certains cas. Contrairement à la simulation, les capteurs du monde réel rencontrent du bruit qui peut s’accumuler et affecter le résultat. Ainsi, pour certaines expériences impliquant un placement de pied de haute précision, les chercheurs ont utilisé un système de capture de mouvement pour mesurer la position réelle du robot.

Leur système a surpassé les autres qui n’utilisent qu’un seul contrôleur, et le mini guépard a traversé avec succès 90 % des terrains.

« Une nouveauté de notre système est qu’il ajuste la démarche du robot. Si un humain essayait de sauter par-dessus un très large écart, il pourrait commencer par courir très vite pour prendre de la vitesse, puis il pourrait mettre les deux pieds ensemble pour faire un bond vraiment puissant à travers l’écart. De la même manière, notre robot peut ajuster les horaires et la durée de ses contacts avec les pieds pour mieux traverser le terrain », explique Margolis.

Sautant hors du laboratoire

Alors que les chercheurs ont pu démontrer que leur système de contrôle fonctionne en laboratoire, ils ont encore un long chemin à parcourir avant de pouvoir déployer le système dans le monde réel, explique Margolis.

À l’avenir, ils espèrent monter un ordinateur plus puissant sur le robot afin qu’il puisse effectuer tous ses calculs à bord. Ils veulent également améliorer l’estimateur d’état du robot pour éliminer le besoin du système de capture de mouvement. En outre, ils aimeraient améliorer le contrôleur de bas niveau afin qu’il puisse exploiter toute la gamme de mouvements du robot, et améliorer le contrôleur de haut niveau afin qu’il fonctionne bien dans différentes conditions d’éclairage.

“Il est remarquable de constater la flexibilité des techniques d’apprentissage automatique capables de contourner les processus intermédiaires soigneusement conçus (par exemple, l’estimation d’état et la planification de trajectoire) sur lesquels des techniques basées sur des modèles séculaires se sont appuyées”, a déclaré Kim. « Je suis enthousiasmé par l’avenir des robots mobiles avec un traitement de la vision plus robuste spécialement formé pour la locomotion. »

Référence : « Learning to Jump from Pixels » de Gabriel B Margolis, Tao Chen, Kartik Paigwar, Xiang Fu, Donghyun Kim, Sang bae Kim et Pulkit Agrawal, 19 juin 2021, Conférence CoRL 2021.

OuvrirReview

La recherche est financée, en partie, par le laboratoire d’IA improbable du MIT, le laboratoire de robotique biomimétique, NAVER LABS et le DARPA Programme de bon sens de la machine.