La technique d’intelligence artificielle Ballyhooed connue sous le nom de « deep learning » fait revivre une idée vieille de 70 ans.

Au cours des 10 dernières années, les systèmes d’intelligence artificielle les plus performants, tels que les reconnaissances vocales sur les smartphones ou le dernier traducteur automatique de Google, ont résulté d’une technique appelée « deep learning ».

L’apprentissage profond est en fait un nouveau nom pour une approche de l’intelligence artificielle appelée réseaux de neurones, qui est à la mode depuis plus de 70 ans. Les réseaux de neurones ont été proposés pour la première fois en 1944 par Warren McCullough et Walter Pitts, deux Université de Chicago chercheurs qui ont déménagé AVEC en 1952 en tant que membres fondateurs de ce qu’on appelle parfois le premier département des sciences cognitives.

Les réseaux neuronaux ont été un domaine de recherche majeur en neurosciences et en informatique jusqu’en 1969, date à laquelle, selon la tradition informatique, ils ont été tués par les mathématiciens du MIT Marvin Minsky et Seymour Papert, qui un an plus tard deviendraient codirecteurs du nouveau laboratoire d’intelligence artificielle du MIT.

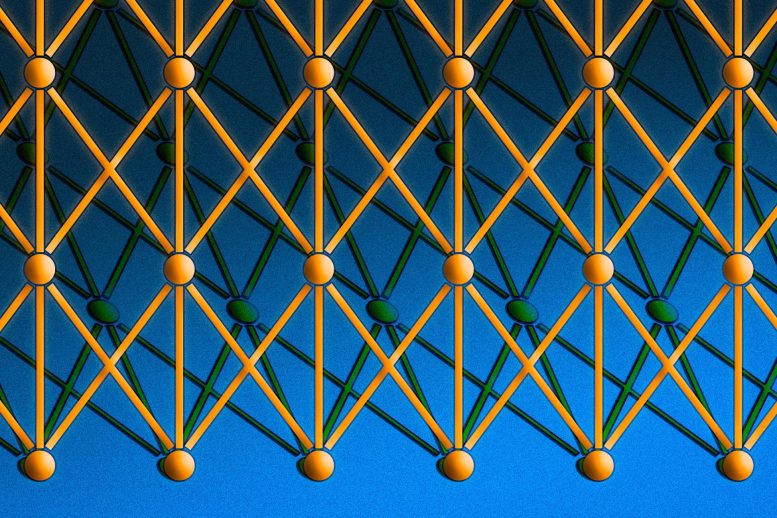

La plupart des applications d’apprentissage en profondeur utilisent des réseaux de neurones «convolutifs», dans lesquels les nœuds de chaque couche sont regroupés, les clusters se chevauchent et chaque cluster alimente en données plusieurs nœuds (orange et vert) de la couche suivante. Crédit : José-Luis Olivares/MIT

La technique a ensuite connu une résurgence dans les années 1980, s’est à nouveau éclipsée dans la première décennie du nouveau siècle, et est revenue comme des gangbusters dans la seconde, alimentée en grande partie par la puissance de traitement accrue des puces graphiques.

“Il y a cette idée que les idées en science sont un peu comme des épidémies de virus”, explique Tomaso Poggio, professeur Eugene McDermott de sciences du cerveau et de la cognition au MIT, chercheur au McGovern Institute for Brain Research du MIT et directeur du Center for Brains du MIT. , les esprits et les machines. « Il existe apparemment cinq ou six souches de base de virus de la grippe, et apparemment chacune revient avec une période d’environ 25 ans. Les gens sont infectés et développent une réponse immunitaire, et donc ils ne sont pas infectés pendant les 25 prochaines années. Et puis il y a une nouvelle génération qui est prête à être infectée par la même souche de virus. En science, les gens tombent amoureux d’une idée, s’en enthousiasment, la martèlent à mort, puis se font immuniser – ils en ont marre. Donc les idées devraient avoir le même genre de périodicité !

Questions importantes

Les réseaux neuronaux sont un moyen de faire de l’apprentissage automatique, dans lequel un ordinateur apprend à effectuer une tâche en analysant des exemples de formation. Habituellement, les exemples ont été étiquetés à la main à l’avance. Un système de reconnaissance d’objets, par exemple, pourrait recevoir des milliers d’images étiquetées de voitures, de maisons, de tasses à café, etc., et il trouverait des motifs visuels dans les images qui correspondent systématiquement à des étiquettes particulières.

Modélisé vaguement sur le cerveau humain, un réseau neuronal se compose de milliers, voire de millions de nœuds de traitement simples qui sont densément interconnectés. La plupart des réseaux neuronaux d’aujourd’hui sont organisés en couches de nœuds, et ils sont « feed-forward », ce qui signifie que les données les traversent dans une seule direction. Un nœud individuel peut être connecté à plusieurs nœuds de la couche sous-jacente, à partir de laquelle il reçoit des données, et à plusieurs nœuds de la couche supérieure, auxquels il envoie des données.

À chacune de ses connexions entrantes, un nœud attribuera un numéro appelé « poids ». Lorsque le réseau est actif, le nœud reçoit un élément de données différent – un nombre différent – sur chacune de ses connexions et le multiplie par le poids associé. Il additionne ensuite les produits résultants, donnant un seul nombre. Si ce nombre est inférieur à une valeur seuil, le nœud ne transmet aucune donnée à la couche suivante. Si le nombre dépasse la valeur seuil, le nœud « se déclenche », ce qui, dans les réseaux de neurones d’aujourd’hui, signifie généralement envoyer le nombre – la somme des entrées pondérées – le long de toutes ses connexions sortantes.

Lorsqu’un réseau neuronal est en cours d’apprentissage, tous ses poids et seuils sont initialement définis sur des valeurs aléatoires. Les données d’entraînement sont transmises à la couche inférieure – la couche d’entrée – et elles traversent les couches suivantes, se multiplient et s’additionnent de manière complexe, jusqu’à ce qu’elles arrivent enfin, radicalement transformées, à la couche de sortie. Pendant l’entraînement, les poids et les seuils sont continuellement ajustés jusqu’à ce que les données d’entraînement avec les mêmes étiquettes produisent systématiquement des sorties similaires.

Esprits et machines

Les réseaux neuronaux décrits par McCullough et Pitts en 1944 avaient des seuils et des poids, mais ils n’étaient pas organisés en couches, et les chercheurs n’ont spécifié aucun mécanisme d’entraînement. Ce que McCullough et Pitts ont montré, c’est qu’un réseau neuronal pouvait, en principe, calculer n’importe quelle fonction qu’un ordinateur numérique pouvait. Le résultat était plus la neuroscience que l’informatique : le but était de suggérer que le cerveau humain pouvait être considéré comme un appareil informatique.

Les réseaux neuronaux continuent d’être un outil précieux pour la recherche neuroscientifique. Par exemple, particulier dispositions de réseau ou règles pour ajuster les poids et les seuils ont reproduit les caractéristiques observées de la neuroanatomie et de la cognition humaines, une indication qu’elles capturent quelque chose sur la façon dont le cerveau traite l’information.

Le premier réseau de neurones pouvant être entraîné, le Perceptron, a été démontré par le psychologue de l’Université Cornell Frank Rosenblatt en 1957. La conception du Perceptron ressemblait beaucoup à celle du réseau de neurones moderne, sauf qu’il n’avait qu’une seule couche avec des poids et des seuils réglables, pris en sandwich entre les entrées et les couches de sortie.

Les perceptrons étaient un domaine de recherche actif à la fois en psychologie et dans la discipline naissante de l’informatique jusqu’en 1959, lorsque Minsky et Papert ont publié un livre intitulé « Perceptrons », qui démontrait que l’exécution de certains calculs assez courants sur les Perceptrons prendrait beaucoup de temps.

“Bien sûr, toutes ces limitations disparaissent en quelque sorte si vous prenez des machines un peu plus compliquées, comme deux couches”, explique Poggio. Mais à l’époque, le livre avait un effet dissuasif sur la recherche sur les réseaux neuronaux.

« Vous devez replacer ces choses dans leur contexte historique », dit Poggio. « Ils plaidaient pour la programmation – pour des langages comme Lisp. Peu d’années auparavant, les gens utilisaient encore des ordinateurs analogiques. Il n’était pas clair du tout à l’époque que la programmation était la voie à suivre. Je pense qu’ils sont allés un peu trop loin, mais comme d’habitude, ce n’est pas noir et blanc. Si vous pensez à cela comme à cette compétition entre l’informatique analogique et l’informatique numérique, ils se sont battus pour ce qui était à l’époque la bonne chose.

Périodicité

Dans les années 1980, cependant, les chercheurs avaient développé des algorithmes pour modifier les poids et les seuils des réseaux neuronaux qui étaient suffisamment efficaces pour les réseaux à plusieurs couches, supprimant bon nombre des limitations identifiées par Minsky et Papert. Le domaine a connu une renaissance.

Mais intellectuellement, il y a quelque chose d’insatisfaisant dans les réseaux neuronaux. Une formation suffisante peut réviser les paramètres d’un réseau au point de pouvoir classer utilement les données, mais que signifient ces paramètres ? Quelles caractéristiques d’image un outil de reconnaissance d’objets regarde-t-il, et comment les assemble-t-il dans les signatures visuelles distinctives des voitures, des maisons et des tasses à café ? Regarder les poids des connexions individuelles ne répondra pas à cette question.

Ces dernières années, les informaticiens ont commencé à ingénieux méthodes pour déduire les stratégies analytiques adoptées par les réseaux de neurones. Mais dans les années 1980, les stratégies des réseaux étaient indéchiffrables. Ainsi, au tournant du siècle, les réseaux de neurones ont été supplantés par les machines à vecteurs de support, une approche alternative de l’apprentissage automatique basée sur des mathématiques très propres et élégantes.

La récente résurgence des réseaux de neurones – la révolution de l’apprentissage en profondeur – est une gracieuseté de l’industrie des jeux informatiques. L’imagerie complexe et le rythme rapide des jeux vidéo d’aujourd’hui nécessitent un matériel qui peut suivre, et le résultat a été l’unité de traitement graphique (GPU), qui regroupe des milliers de cœurs de traitement relativement simples sur une seule puce. Il n’a pas fallu longtemps aux chercheurs pour se rendre compte que l’architecture d’un GPU ressemble remarquablement à celle d’un réseau de neurones.

Les GPU modernes ont permis aux réseaux à une couche des années 1960 et aux réseaux à deux ou trois couches des années 1980 de devenir les réseaux à 10, 15, voire 50 couches d’aujourd’hui. C’est ce à quoi le « deep » dans « deep learning » fait référence – la profondeur des couches du réseau. Et actuellement, l’apprentissage en profondeur est responsable des systèmes les plus performants dans presque tous les domaines de la recherche en intelligence artificielle.

Sous la capuche

L’opacité des réseaux est toujours troublante pour les théoriciens, mais il y a aussi des progrès sur ce front. En plus de diriger le Center for Brains, Minds, and Machines (CBMM), Poggio dirige le programme de recherche du centre en Cadres théoriques pour l’intelligence. Récemment, Poggio et ses collègues du CBMM ont publié une étude théorique en trois parties sur les réseaux de neurones.

Les première partie, qui a été publié dans le Journal international de l’automatisation et de l’informatique, aborde la gamme de calculs que les réseaux d’apprentissage en profondeur peuvent exécuter et quand les réseaux profonds offrent des avantages par rapport aux réseaux moins profonds. les pièces deux et Trois, qui ont été publiés sous forme de rapports techniques CBMM, abordent les problèmes d’optimisation globale, ou garantissant qu’un réseau a trouvé les paramètres qui correspondent le mieux à ses données d’entraînement, et le surapprentissage, ou les cas dans lesquels le réseau devient tellement adapté aux spécificités de ses données d’apprentissage qu’il ne parvient pas à généraliser à d’autres instances des mêmes catégories.

Il reste encore de nombreuses questions théoriques à résoudre, mais les travaux des chercheurs du CBMM pourraient aider à garantir que les réseaux de neurones rompent enfin le cycle générationnel qui les a rendus populaires et défavorisés depuis sept décennies.