Comme beaucoup de Internet, PubPeer est le genre d’endroit où vous voudrez peut-être rester anonyme. Là, sous des noms taxonomiques attribués au hasard comme Actinopolyspora biskrensis (une bactérie) et Hoya camphorifolia (une plante à fleurs), les « détectives » documentent méticuleusement les erreurs de la littérature scientifique. Bien qu’ils écrivent sur toutes sortes d’erreurs, des statistiques ratées à la méthodologie absurde, leur expertise collective réside dans les images manipulées : des nuages de protéines qui montrent des bords étrangement nets ou des arrangements identiques de cellules dans deux expériences supposées distinctes. Parfois, ces irrégularités ne signifient rien de plus que le fait qu’un chercheur a tenté d’embellir une figure avant de la soumettre à un journal. Mais ils lèvent néanmoins des drapeaux rouges.

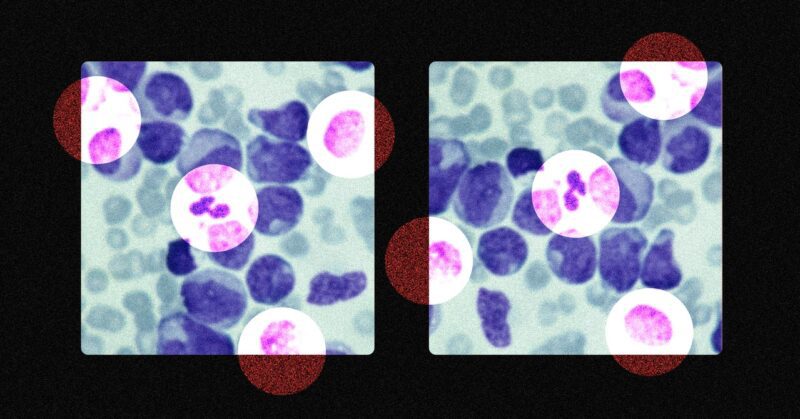

La communauté raréfiée de détectives scientifiques de PubPeer a produit une célébrité improbable : Elisabeth Bik, qui utilise son incroyable acuité pour repérer des duplications d’images qui seraient invisibles pour pratiquement tout autre observateur. De telles duplications peuvent permettre aux scientifiques d’évoquer des résultats à partir de rien en regroupant des parties de nombreuses images ou de prétendre qu’une image représente deux expériences distinctes qui ont produit des résultats similaires. Mais même l’œil surnaturel de Bik a ses limites : il est possible de simuler des expériences sans utiliser la même image deux fois. “S’il y a un peu de chevauchement entre les deux photos, je peux vous clouer”, dit-elle. “Mais si vous déplacez l’échantillon un peu plus loin, il n’y a pas de chevauchement à trouver.” Lorsque l’expert le plus visible au monde ne peut pas toujours identifier la fraude, la combattre, voire l’étudier, peut sembler impossible.

Néanmoins, de bonnes pratiques scientifiques peuvent réduire efficacement l’impact de la fraude – c’est-à-dire du faux pur et simple – sur la science, qu’elle soit découverte ou non. La fraude “ne peut pas être exclue de la science, tout comme nous ne pouvons pas exclure le meurtre dans notre société”, déclare Marcel van Assen, chercheur principal au Meta-Research Center de la Tillburg School of Social and Behavioral Sciences. Mais alors que les chercheurs et les défenseurs continuent de pousser la science à être plus ouverte et impartiale, dit-il, la fraude “sera moins répandue à l’avenir”.

Aux côtés de détectives comme Bik, des « métascientifiques » comme van Assen sont les experts mondiaux de la fraude. Ces chercheurs suivent systématiquement la littérature scientifique dans le but de s’assurer qu’elle est aussi précise et robuste que possible. La métascience existe dans son incarnation actuelle depuis 2005, lorsque John Ioannidis – un professeur de l’Université de Stanford autrefois loué qui est récemment tombé en discrédit pour ses opinions sur la pandémie de Covid-19, comme une opposition farouche aux verrouillages – a publié un article avec le titre provocateur “Pourquoi la plupart des résultats de recherche publiés sont faux”. La petite taille des échantillons et les biais, a expliqué Ioannidis, signifient que des conclusions incorrectes se retrouvent souvent dans la littérature, et ces erreurs sont trop rarement découvertes, car les scientifiques préfèrent de loin poursuivre leurs propres programmes de recherche plutôt que d’essayer de reproduire le travail de leurs collègues. Depuis cet article, les métascientifiques ont perfectionné leurs techniques d’étude des biais, un terme qui couvre tout, depuis les soi-disant “pratiques de recherche douteuses” – ne pas publier de résultats négatifs ou appliquer des tests statistiques encore et encore jusqu’à ce que vous trouviez quelque chose d’intéressant, par exemple – à la fabrication pure et simple ou à la falsification de données.

Ils prennent le pouls de ce biais en examinant non pas des études individuelles, mais des tendances générales dans la littérature. Lorsque de petites études sur un sujet particulier ont tendance à montrer des résultats plus spectaculaires que des études plus importantes, par exemple, cela peut être un indicateur de biais. Les petites études sont plus variables, donc certaines d’entre elles finiront par être dramatiques par hasard – et dans un monde où les résultats spectaculaires sont favorisés, ces études seront publiées plus souvent. D’autres approches consistent à examiner les valeurs p, des nombres qui indiquent si un résultat donné est statistiquement significatif ou non. Si, dans la littérature sur une question de recherche donnée, trop de valeurs p semblent significatives et trop peu ne le sont pas, les scientifiques peuvent utiliser des approches douteuses pour essayer de rendre leurs résultats plus significatifs.

Mais ces modèles n’indiquent pas dans quelle mesure ce biais est attribuable à la fraude plutôt qu’à une analyse de données malhonnête ou à des erreurs innocentes. Il y a un sens dans lequel la fraude est intrinsèquement non mesurable, explique Jennifer Byrne, professeur d’oncologie moléculaire à l’Université de Sydney, qui a travaillé pour identifier les articles potentiellement frauduleux dans la littérature sur le cancer. « La fraude est une question d’intention. C’est un état d’esprit psychologique », dit-elle. « Comment déduire un état d’esprit et une intention à partir d’un article publié ? »