Pour emprunter un vieux cliché, ChatGPT-4 a cassé Internet. La dernière itération du chatbot d’IA le plus avancé du laboratoire de recherche sur l’intelligence artificielle OpenAI a été publiée le 14 mars, générant immédiatement un battage médiatique considérable autour d’une technologie qui attire à parts égales le techno-utopisme ou l’apocalypse robotique. Il peut répondre aux questions avec un langage naturel et humain, donnant l’illusion qu’il y a plus qu’un simple code à l’autre bout de la fenêtre de dialogue. En d’autres termes, certains perçoivent ChatGPT comme une IA sensible, comme quelque chose de la science-fiction hollywoodienne.

GPT-4 (abréviation de Generative Pre-trained Transformer) est présenté comme exponentiellement supérieur à son prédécesseur GPT-3, formé sur un ensemble de données beaucoup plus étendu qui lui a permis de fonctionner avec des performances de niveau humain sur de nombreux critères académiques.

“Je ne dis pas qu’aucune de ces choses ne sont des arnaques, mais c’est exactement ce que font les escrocs. Ils exploitent vos propres sentiments et la façon dont vous sympathisez avec le monde.”

Il peut passer de nombreux examens de haut niveau (mais pas tous), y compris le LSAT, avec brio, générer un ensemble site web à partir d’un dessin sur serviette, inventer de nouveaux médicaments avant de les commander chez un fournisseur, et coder une version fonctionnelle du jeu vidéo”Pong” en seulement 60 secondes. (Certaines de ces affirmations ne sont pas faciles à vérifier de manière indépendante, alors prenez les publications sur les réseaux sociaux avec un grain de sel.)

OpenAI a promis que GPT-4 est plus sûr que GPT-3, avec plus de filtres intégrés et moins de possibilité d’être manipulé pour dire des choses dangereuses, telles que des instructions de fabrication pour des armes biologiques. Mais bien qu’il y ait des améliorations, le New York Times rapporte que le GPT-4 présente toujours des défauts, notamment la tendance à halluciner ou à donner de fausses informations présentées avec confiance comme des faits.

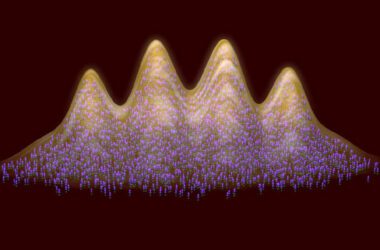

GPT-4 est un exemple de la course aux armements de l’IA, dans laquelle plusieurs entreprises développent des plates-formes avec une technologie étonnante qui était quelque peu impensable il y a encore quelques mois, y compris les générateurs de texte en image comme Midjourney et le réseau souterrain deepfake utilisé pour générer fausses vidéos. Cette technologie est rendue publique à un rythme effréné et avant même que la culture dans son ensemble ne puisse vraiment réagir, une autre mise à niveau est sortie.

Dans ce contexte, la Silicon Valley traverse une sorte de crise financière. L’effondrement le 10 mars de la Silicon Valley Bank, qui était responsable du capital de nombreuses start-up technologiques, a marqué la deuxième plus grande faillite bancaire de l’histoire des États-Unis. Pendant ce temps, Microsoft a licencié toute son équipe Éthique et société le 13 mars (ce qui semble être le genre d’employés qui seraient critiques à un moment comme celui-ci), dans le cadre d’une tendance plus large de licenciements d’entreprises technologiques.

Tout cela pourrait détourner l’attention de questions fondamentales plus importantes, comme comment fonctionne tout cela, de toute façon ? Où nous mène-t-il ? Et quelles sont les répercussions sociales à mesure que la technologie de l’IA s’améliore ?

Salon s’est entretenu avec Chirag Shah, professeur de science des données à l’Université de Washington à Seattle, dont l’objectif principal est de savoir comment les gens trouvent des informations et comment ils les utilisent. Non seulement il est préoccupé par la construction de ce type de systèmes de renseignement, mais il est également confronté à des problèmes de partialité, d’équité, de responsabilité et de transparence – ce qui relève généralement de la catégorie de l’IA responsable. Nous avons discuté de certaines des bases de l’IA, pourquoi il y a tant de battage médiatique (et le test de Turing n’est pas fiable), et plus encore.

Cette interview a été condensée et légèrement modifiée pour plus de clarté.

Honnêtement, je ne suis pas le plus grand nerd de la technologie. Mais depuis le LaMDA [Language Model for Dialogue Applications] l’histoire s’est passée l’été dernier, [in which Blake Lemoine, an engineer at Google, claimed that a chatbot had become sentient], j’ai été super intéressé par l’IA. J’ai expérimenté tous ces outils aléatoires, mais il y a tout ce battage médiatique autour de cette technologie et aussi beaucoup de bavardages de la part des gens que cette technologie est fatale pour la société. Quelle est la gravité de certaines de ces préoccupations ?

Oui, nous sommes définitivement fascinés par cela. Il ne se passe presque aucun jour sans que quelqu’un ne me parle de ChatGPT – en fait à l’échelle mondiale. Je viens de rentrer de Singapour et de l’Inde la semaine dernière. Partout, les gens sont conscients de cela, ils en parlent.

Lorsque nous parlons d’IA, il y a généralement trois catégories ou niveaux : il y a l’ANI, qui est “l’intelligence étroite artificielle” ; AGI, qui est “l’intelligence générale artificielle” ; et ASI, “super intelligence artificielle”. Nous sommes habitués à ANI depuis longtemps. Pensez aux programmes de jeu d’échecs, je veux dire, c’est un exemple d’un système d’IA qui existe depuis des décennies maintenant. Et ils sont devenus bons, ils sont devenus excellents.

“Il ne s’agit pas de machines qui se lèvent, comme tout le scénario” Terminator “. Mais je ne vois pas non plus que cela soit le sauveur que nous espérions.”

Mais ce à quoi nous assistons maintenant, c’est à cette évolution vers l’AGI, qui est [where] vous avez un système ou une entité qui a une intelligence générale. je [think] c’est du battage médiatique, je ne crois pas que ces systèmes aient vraiment atteint cela ou soient même proches de cela. Mais les gens ont commencé à l’extrapoler.

Je pense que c’est la grande déconnexion. Ces choses ont été conçues pour exceller dans des tâches spécifiques. Et ils l’ont prouvé. Ils sont encore plus un ANI, mais parce qu’ils le font en langage naturel, cela commence à vous donner une illusion de cette intelligence générale.

Nous oublions souvent que dans toute notre histoire, les seules autres entités avec lesquelles nous avons eu des interactions en langage naturel sont d’autres humains. Pour la première fois, nous avons ces entités qui comprennent le langage naturel et répondent en langage naturel. Et c’est arrivé assez soudainement. Nous n’étions pas préparés.

La chose LaMDA est tellement intéressante. Je dois admettre que lorsque j’ai lu pour la première fois ces conversations avec Blake Lemoine, j’étais un peu convaincu, car certaines des choses qu’il faisait étaient, comme vous le dites, une illusion. Mais c’est très convaincant.

Puis, il y a quelques mois, j’ai commencé à utiliser ChatGPT et à interagir avec cette technologie. Cela ne me semblait vraiment pas sensible, c’était comme: “Oh, c’est vraiment juste un programme de traitement du langage naturel. Il a beaucoup de limites.”

Mais disons que LaMDA ou ChatGPT étaient sensibles. Comment pouvons-nous même prouver cela? Si nous allons vers cet objectif d’AGI et d’ASI, comment savons-nous quand nous l’atteignons ?

Je pense que la méthode traditionnelle que nous avons tous étudiée à l’école, le test de Turing, n’est plus pertinente ou utile maintenant. Il peut facilement être dépassé par beaucoup de ces choses. Cela vous donne suffisamment d’illusions sur le fait que vous ne pouvez pas faire la différence entre un être humain et une entité artificielle. Il passe déjà toutes sortes de tests, des tests standardisés, etc.

Même avant tout cela, beaucoup ont critiqué le fait que le test de Turing n’est vraiment pas la bonne mesure de l’intelligence. Je pense donc que cela revient vraiment à une discussion plus philosophique sur ce que nous considérons comme l’intelligence. Et, vous savez, je veux dire, si clairement que ces choses sont, nous dirions, ou beaucoup diront qu’elles sont vraiment douées pour faire semblant d’être intelligentes.

Mais on dirait que même si c’est vrai, c’est peut-être ça — c’est une mesure de l’intelligence. Et si quelqu’un faisait semblant ? Même les êtres humains ont le syndrome de l’imposteur.

L’autre récit ici est que cela n’a même pas d’importance. Comme pourquoi devons-nous même mesurer cela? Pourquoi devons-nous même dire : « Oh, nous avons atteint ce seuil, cette étape importante » – parce qu’en fin de compte, nous voulons juste voir le résultat. Que ce soit fait par une entité étiquetée comme IA ou AGI, qui s’en soucie ? Nous nous soucions du résultat, n’est-ce pas ? Et donc peut-être que nous n’avons pas besoin d’étiqueter les choses autant que nous le voudrions. Tout est une question de perception de toute façon.

Ouais, je pense que si Turing était encore en vie, même lui dirait : “Pourquoi utilisez-vous encore cette métrique des années 1950 ?” Mais je ne pense pas que les gens connaissent vraiment d’autres tests de sensibilité qui existent. Je veux dire, il y a celui de “Blade Runner”. Mais rien d’autre n’est vraiment dans le lexique populaire que je connaisse. Tu as peut-être raison, c’est en quelque sorte hors de propos d’essayer de prouver la sensibilité. Nous devrions vraiment parler davantage de la façon dont ces outils sont utilisés et de qui y a accès, comme la société s’appelle OpenAI. Mais ironiquement, ils ne sont pas très transparents, je pense.

Oh non. En fait, ils sont très clairs sur le fait de ne pas révéler leur processus sous-jacent et de nombreux autres détails. Donc, dans toute leur documentation de 100 pages à ce sujet, ils ne vous disent pas comment ils entraînent ces choses, en particulier, quelles données vous utilisez, quels sont leurs paramètres et toutes ces choses. Et je ne pense pas qu’ils aient l’intention de le faire parce que maintenant c’est un secret commercial, une chose exclusive qui leur donne un avantage concurrentiel.

“Est-ce que c’est ce que nous voulons faire? Est-ce que c’est ce que nous devrions faire? Nous n’avons pas posé ces questions. Nous n’avons pas non plus de réglementation pour arrêter tout cela.”

Mais ce n’est pas nouveau non plus. Je veux dire, Google ne révèle pas son algorithme de classement, n’est-ce pas ? Nous avons une bonne idée de ce qu’il contient, mais nous ne savons pas avec certitude. Nous avons été d’accord avec ça. Nous utilisons certainement beaucoup d’outils dont nous ne comprenons pas le fonctionnement. La plupart des outils que nous utilisons ne sont pas open source, n’est-ce pas ? Et nous les utilisons tous les jours, mais nous avons une idée de ce qu’ils peuvent faire et de ce qu’ils ne peuvent pas faire, de ce qu’ils ne devraient pas faire avec eux.

Le défi ici n’est pas tant que ces choses manquent de transparence. Mais notre propre compréhension n’est pas compatible avec la façon dont nous avons tendance à utiliser ces choses, même pour les choses pour lesquelles elles ne sont pas conçues. Et c’est là que la transparence devient très importante.

Ainsi, lorsque les gens commencent à l’utiliser, par exemple, pour un diagnostic médical, beaucoup diront “eh bien, ce n’est pas pour cela qu’il est vraiment conçu. Ce n’est pas un expert médical.” Mais les gens ne comprennent pas cela.

J’aime ce que vous avez mentionné sur la façon dont nous utilisons l’IA tout le temps dans notre vie quotidienne. Je veux dire, l’IA est utilisée en ce moment sur cet appel Zoom. Il modifiera l’audio pour améliorer la connexion. Plus tard, je vais prendre cette interview et la mettre dans un programme qui me la transcrira. Je vais revenir en arrière et lire toute la transcription et m’assurer qu’elle est exacte, mais généralement je n’ai qu’à corriger une ou deux erreurs par paragraphe. C’est très précis. J’utilise l’IA tout le temps dans mon journalisme quand j’y pense. Quand je fais des recherches, j’utilise l’algorithme de Google.

Mais tu as raison. Les gens doivent comprendre les limites de cette technologie, et ils l’utilisent d’une manière qui ressemble à… ils la poussent un peu plus loin qu’ils ne le devraient probablement et, puis ils obtiennent ce genre de résultats déroutants, comme quand le chatbot Bing est tombé amoureux de quelqu’un. Ou il y a ce journaliste du New York Times qui ne pouvait pas dormir la nuit après lui avoir parlé. C’est juste une sorte de tendance humaine à projeter notre propre conscience sur les choses. C’est comme un aspect psychologique vraiment fascinant, mais c’est aussi quelque chose qui pourrait aussi être exploité.

Exactement. Je ne dis pas que ces choses sont des arnaques, mais c’est exactement ce que font les escrocs. Ils exploitent vos propres sentiments et la façon dont vous sympathisez avec le monde. C’est pourquoi le langage naturel est un aspect si important. C’est ce qui nous relie aux autres êtres humains. Lorsque nous voyons quelqu’un parler notre langue ou suivre notre culture, il appartient à notre tribu, il appartient à notre communauté.

Il y a cette confiance innée que nous avons apprise au cours de milliers d’années d’évolution, et elle nous a en fait été très utile parce que nous ne pouvons pas toujours remettre en question les motivations des autres. C’est ce que ces choses exploitent — elles sont capables de le faire. Ils sont capables de parler comme nous et presque de penser comme nous et même d’exprimer des sentiments comme nous. Vous avez donc tout à fait raison de dire qu’il y a un aspect psychologique à cela. Ces choses ne sont que le reflet de la façon dont nous voulons presque désespérément qu’elles soient comme nous.

Oui, vous soulevez une question vraiment intéressante : voulons-nous même construire des systèmes d’IA sensibles ? C’est juste une question fondamentale. De même, l’IA devrait-elle être utilisée pour faire de l’art, de la poésie et de l’écriture ? Je ne pense pas que l’IA va remplacer les artistes, mais cela rendra le domaine plus compétitif, n’est-ce pas ? Et les artistes pourraient être moins bien payés.

Je pose souvent cette question, “qui a demandé cela?” Les gens projettent leurs besoins là-dessus. “Oh, ChatGPT peut le faire pour moi.” Mais c’est après coup. Nous construisons cette chose et maintenant les gens arrivent. Mais la question reste sans réponse, où allons-nous avec cela? Quel est le but ici ?

Je crois que cela a un impact profond sur… les artistes et les créateurs originaux, ça commence déjà à avoir un impact – ça va avoir un impact profond sur la créativité en général. Car quelle est la valeur de la création originale maintenant que vous pouvez simplement l’utiliser pour faire cette création ?

Et donc c’est plus que simplement des gens qui perdent leur emploi. C’est très fondamental pour nous, pour l’humanité, que nous ayons parcouru ce chemin grâce à notre pensée originale, à la création, aux innovations et à l’esprit d’entreprise. Et maintenant, est-ce qu’on sous-traite ça à cette entité artificielle ? Parce qu’il peut écrire de la poésie et qu’il peut peindre des choses ? Et alors, quelle est la motivation pour nous de faire cela maintenant ?

Je pense donc que c’est en fait très profond, très fondamental pour notre évolution en cours. Je veux dire, nous avons commencé à évoluer, et maintenant nous allons simplement transporter notre histoire, notre façon de penser, notre façon de vivre pendant tous ces milliers d’années vers cette chose. Est-ce ce que nous voulons faire? Est-ce ce que nous devrions faire? Nous n’avons pas posé ces questions. Nous n’avons pas non plus de réglementation pour empêcher tout cela.

Ouais, il semble que personne au Congrès ne soit vraiment conscient des implications. Je ne connais personne qui essaie vraiment de freiner cela ou de réglementer cela du tout.

Imaginez si vous êtes une société pharmaceutique. Pourriez-vous proposer un produit uniquement parce qu’il est efficace ? Non, je veux dire, vous devez passer par tant de tests et d’approbation et tout. Comme, vous savez, vous ne pouvez même pas sortir un dentifrice sans toutes sortes de tests et d’approbations. Mais nous n’avons pas la même chose pour l’IA. Je pense que nous devrions.

Mais mon souhait ne va pas se réaliser, car nous sommes tellement en retard, surtout aux États-Unis. L’Union européenne est plus avancée [regulations], mais en ce qui concerne l’IA, ils sont encore un peu en retard. Et pour être honnête, je n’ai pas beaucoup d’espoir qui me rattrape un jour. Mais je souhaite que nous puissions au moins réduire l’écart. Nous pouvons au moins avoir des garde-fous, une réglementation, une politique qui oblige ces entreprises à au moins avoir une certaine responsabilité.

Il ne s’agit pas de machines qui se lèvent, comme tout le scénario “Terminator”. Mais je ne vois pas non plus cela être le sauveur que nous espérions. Je ne pense pas que cela va fondamentalement tout améliorer et tout changer. Je n’achète pas non plus dans le battage médiatique de l’IA. Ce n’est ni l’un ni l’autre de ces extrêmes. La vérité est quelque part au milieu.

Il y a certainement des avantages à cela. Cela va beaucoup changer et nous devons en être conscients. Et c’est sûr que ça a ce côté nocif, il y a des préjugés, il y a des hallucinations. Mais encore une fois, vous savez, cela ne va pas vraiment détruire l’humanité. Nous n’avons donc pas non plus besoin de le craindre, nous devons le comprendre et nous devons l’embrasser.

Et nous devons nous demander quelle est la prochaine étape pour nous ? Qu’est-ce que cela signifie pour nous individuellement et pour la société ? Où voulons-nous aller avec cela et jusqu’où ? Ce sont les questions que nous voulons poser, afin de ne pas nous laisser surprendre. Ce que nous ne voulons pas, c’est que quelque chose se passe à notre insu et sans notre type d’intention et puis tout à coup, nous devons y faire face. Je veux que ce soit un développement intentionnel à l’avenir.